Wie steht es um die Fairness bei künstlicher Intelligenz? – Das Beispiel der Kreditvergabe

Horváth

Entscheidungen werden von Algorithmen & Künstlicher Intelligenz getroffen – ob im Straßenverkehr, im Finanzwesen oder im Gesundheitssektor. Wie es um die Fairness dieser Entscheidungen und damit ihre Akzeptanz in der breiten Bevölkerung steht, ist eine ganz entscheidende Frage für den Einsatz von Künstlicher Intelligenz. Am Beispiel der Kreditvergabe …

von Benjamin Grether, Experte für Artificial Intelligence (AI) und Machine Learning bei der Managementberatung Horváth

Bisher waren die Unternehmen, die Teile ihrer Geschäfte datengetriebener gestalten wollten, noch zu sehr damit beschäftigt, in ihren Prozessen sinnvolle und umsetzbare so genannte Use Cases, also Anwendungsfälle, für Algorithmen zu finden. Dabei geht es um die Entwicklung von Modellen, die exakte Ergebnisse für eine produktive Umsetzung liefern. Diese anfänglichen Hürden sind in den meisten dieser Organisationen jetzt überwunden. Es liegen algorithmische Lösungen vor, die das Potenzial haben, Prozesse signifikant zu verbessern – beispielweise in Form von Zeit- und Kostenersparnissen.Drängend stellt sich nun die Frage, ob die Entscheidungen der von ihnen eingesetzten Algorithmen frei von Diskriminierung gegenüber Kunden und Mitarbeitern sind.”

Haftungs- und Reputationsrisiken erhöhen den Handlungsdruck

Gesellschaftlich werden die Themen Gleichstellung und Diversity immer wichtiger. Unternehmen und damit ihr Management sind verantwortlich für diskriminierungsfreie Prozesse.

Die Unternehmen sind verpflichtet, die Funktionsweisen der von ihnen eingesetzten Algorithmen zu kennen und zu steuern.”

Kommt es zu Diskriminierung aufgrund einer von Algorithmen getroffenen Entscheidung, haften die Firmen für etwaige Schäden und müssen darüber hinaus mit Reputationsschäden rechnen, die ihr Image in Verruf bringen und dem gesamten Geschäft langfristig schaden. Eine systematische Diskriminierung durch Algorithmen birgt ein noch größeres Schadenpotenzial als menschliche Fehlentscheidungen, die gesellschaftlich noch als eben solche akzeptiert beziehungsweise als Einzelfälle eingestuft werden. Algorithmen können in Daten vorhandene Ungleichheiten sogar noch verstärken.

Um zu verhindern, dass Algorithmen diskriminierende Entscheidungen treffen, gilt es zunächst zu verstehen, wie sie überhaupt „voreingenommen“ werden.”

Im nächsten Schritt müssen faire Entscheidungen mathematisch definiert und dadurch messbar gemacht werden. Zum Schluss gilt es, den Algorithmen durch Machine-Learning-Methoden bestmögliche Fairness anzutrainieren, also eine weitmögliche Reduzierung von Vorurteilen zu erreichen.

Was macht Algorithmen voreingenommen?

Autor Benjamin Grether, Horváth Benjamin Grether ist Senior Data Scientist und Experte für Artificial Intelligence (AI) und Machine Learning bei der Managementberatung Horváth (Website). Zuvor war er als Analyst und Researcher bei verschiedenen Organisationen tätig. Grether hat einen Masterstudiengang in Mathematik an der TU München absolviert, seine Thesis am Londoner Imperial College erarbeitet. Eine weitere Station seines Studiums ist die Pennsylvania State University.KI-gestützte Entscheidungen sollten eigentlich per se objektiver und weniger fehleranfällig sein als menschliche, so zumindest die allgemeine Vorstellung. Dies ist jedoch ein Trugschluss. Die Fairness von Algorithmen hängt von verschiedenen Parametern ab. Um ein Machine-Learning-Modell zu trainieren – also das Verarbeitungsmodell, in dem ein Algorithmus zum Einsatz kommt, werden Daten benötigt. Diese tragen häufig eine Verzerrung in sich, beispielsweise ein Übergewicht an Beobachtungen einer bestimmten Gruppe, die sich beim Trainieren auf das Modell überträgt. In der Fachsprache wird von einem „Bias“ gesprochen, wenn ein Modell eine systematische Verzerrung aufweist.

Benjamin Grether ist Senior Data Scientist und Experte für Artificial Intelligence (AI) und Machine Learning bei der Managementberatung Horváth (Website). Zuvor war er als Analyst und Researcher bei verschiedenen Organisationen tätig. Grether hat einen Masterstudiengang in Mathematik an der TU München absolviert, seine Thesis am Londoner Imperial College erarbeitet. Eine weitere Station seines Studiums ist die Pennsylvania State University.KI-gestützte Entscheidungen sollten eigentlich per se objektiver und weniger fehleranfällig sein als menschliche, so zumindest die allgemeine Vorstellung. Dies ist jedoch ein Trugschluss. Die Fairness von Algorithmen hängt von verschiedenen Parametern ab. Um ein Machine-Learning-Modell zu trainieren – also das Verarbeitungsmodell, in dem ein Algorithmus zum Einsatz kommt, werden Daten benötigt. Diese tragen häufig eine Verzerrung in sich, beispielsweise ein Übergewicht an Beobachtungen einer bestimmten Gruppe, die sich beim Trainieren auf das Modell überträgt. In der Fachsprache wird von einem „Bias“ gesprochen, wenn ein Modell eine systematische Verzerrung aufweist.

Benjamin Grether ist Senior Data Scientist und Experte für Artificial Intelligence (AI) und Machine Learning bei der Managementberatung Horváth (Website). Zuvor war er als Analyst und Researcher bei verschiedenen Organisationen tätig. Grether hat einen Masterstudiengang in Mathematik an der TU München absolviert, seine Thesis am Londoner Imperial College erarbeitet. Eine weitere Station seines Studiums ist die Pennsylvania State University.

Benjamin Grether ist Senior Data Scientist und Experte für Artificial Intelligence (AI) und Machine Learning bei der Managementberatung Horváth (Website). Zuvor war er als Analyst und Researcher bei verschiedenen Organisationen tätig. Grether hat einen Masterstudiengang in Mathematik an der TU München absolviert, seine Thesis am Londoner Imperial College erarbeitet. Eine weitere Station seines Studiums ist die Pennsylvania State University.So machte Amazon bereits 2014 die Erfahrung, dass das neu entwickelte algorithmische System für den unternehmenseigenen Einstellungsprozess, Bewerber für Jobs in der Softwareentwicklung nicht geschlechtsneutral bewertete – und das, obwohl die Information über das Geschlecht der Bewerber dem Algorithmus nicht explizit vorlag. Dies lag daran, dass Amazons Machine-Learning-Modelle darauf trainiert waren, Muster in Lebensläufen zu beobachteten, die dem Unternehmen über den Zeitraum der letzten zehn Jahre vorgelegt wurden. Die meisten Lebensläufe stammten von Männern, was die noch vorherrschende männliche Überrepräsentation in der Tech-Industrie widerspiegelt. Demzufolge war auch der typische erfolgreiche Bewerber in den letzten Jahren männlich. In der Tat hat sich Amazons System dadurch selbst beigebracht, männliche Kandidaten zu bevorzugen. Dagegen wurden beispielsweise Bewerberinnen von Frauen-Colleges herabgestuft, weil ihr Lebenslauf den Begriff „Women“ enthielt – ein Begriff, der im typischen erfolgreichen Lebenslauf nicht zu finden war.

Ziel bei der fairen Modellierung ist es also, ein Modell zu trainieren, das einen möglichst geringen Bias hinsichtlich sensitiver Attribute aufweist und diesen messbar macht. Mit dieser Information können Unternehmen Toleranzen festlegen und entsprechend steuern.

Fairness definieren und messbar machen – am Beispiel Kreditvergabe

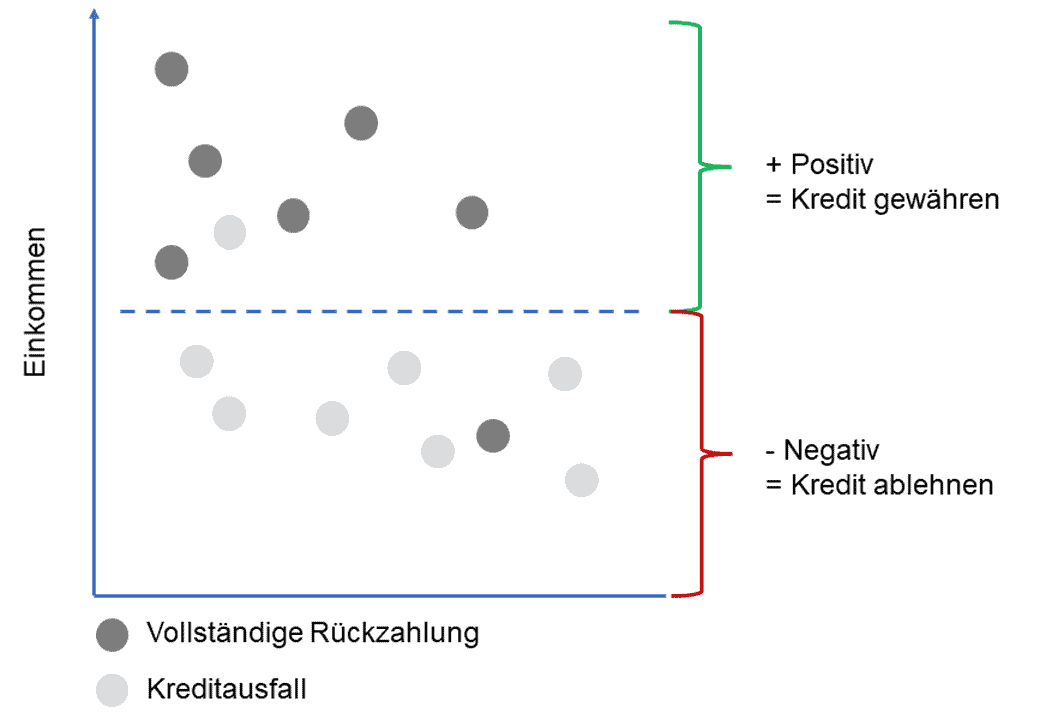

Wie wird Fairness definiert und somit messbar gemacht? Entscheidet sich beispielsweise eine Bank dazu, in Zukunft Kreditentscheidungen aufgrund eines Algorithmus zu fällen, sollte die soziale Herkunft der Antragssteller dabei keine Rolle spielen und die Entscheidung rein an erklärenden Faktoren, wie zum Beispiel dem Einkommen, festgemacht werden. Das heißt, das Modell soll darauf abzielen, die entsprechende Einkommensschwelle zu erlernen, die zuverlässig vorhersagt, ob eine Person ihren Kredit vollständig zurückzahlen kann, ohne dass dabei sensitive Attribute zu einer nachteiligen Entscheidung für eine Gruppe führen.

Horváth

Diejenigen, die mit ihrem Einkommen über dem Schwellenwert liegen (Abb. 1, gestrichelte), erhalten den Kredit aufgrund einer positiven Vorhersage. Diejenigen, die unter dem Schwellenwert liegen, erhalten bei der Kreditvergabe keinen Kredit, da eine negative Vorhersage berechnet wurde. Wie kann in diesem Beispiel nun die Fairness des entscheidenden Algorithmus gemessen und bewertet werden? Dazu werden im Folgenden drei mathematische Definition von Fairness und deren Einfluss auf die Business-Entscheidung betrachtet.

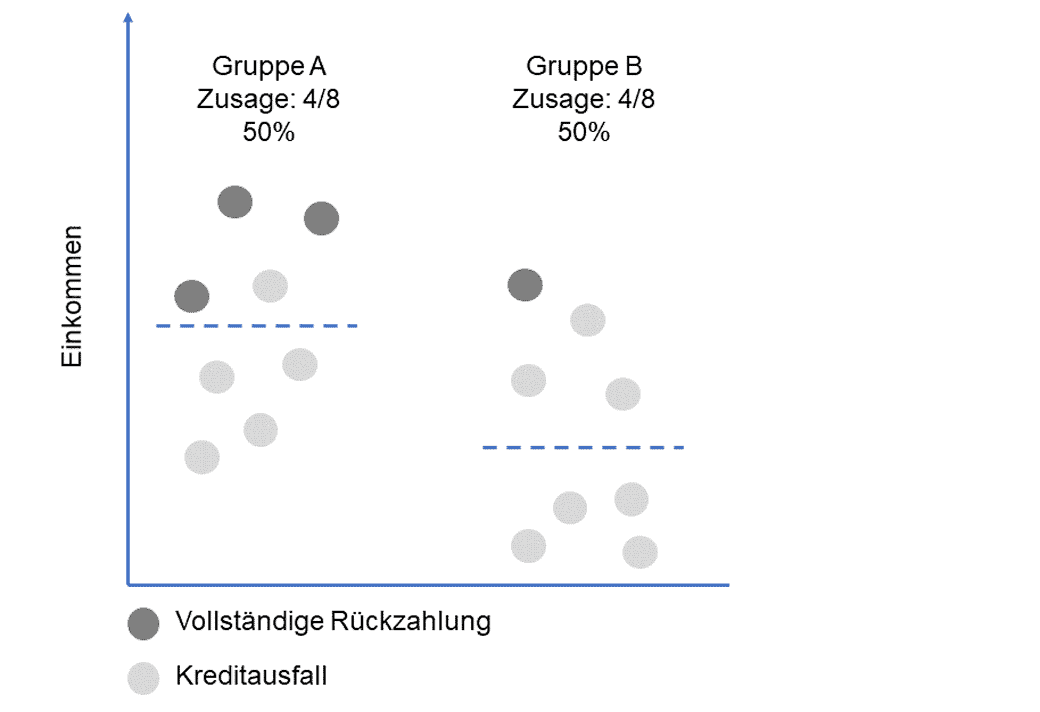

Beispiel 1 für algorithmische Fairness: Proportional Parity

Die erste betrachtete mathematische Definition von Fairness ist die sogenannte „Proportional Parity“. Diese besagt, dass jedes Segment eines geschützten Attributes wie beispielsweise die soziale Herkunft das positive Ergebnis zu gleichen Teilen erhalten sollte. Ein positives Ergebnis ist die bevorzugte Entscheidung, in diesem Beispiel also “einen Kredit erhalten”. Idealerweise sollte der Unterschied in den Zusage-Quoten pro Gruppe gleich Null sein oder zumindest eine gewisse Toleranzabweichung nicht überschreiten. Dies kann zum Beispiel dadurch erreicht werden, dass unterschiedliche Anforderungsniveaus für jede Gruppe verwendet werden, so dass der Prozentsatz der Personen, die eine Kreditzusage in Gruppe A erhalten, gleich dem Prozentsatz der Personen ist, die eine Zusage in Gruppe B erhalten, wie in der folgenden Abbildung veranschaulicht.

Horváth

Mit diesem Kriterium für Fairness wird eine Gleichbehandlung beider Gruppen erreicht. Jedoch wird beim Betrachten der voranstehenden Abbildung auch eines deutlich: das Kriterium berücksichtigt das tatsächliche Risiko eines Kreditausfalls in beiden Gruppen nicht und kann damit zu schlechten wirtschaftlichen Entscheidungen führen.

Auf der anderen Seite bietet diese Lösung die Chance, die Nachteile, die Gruppe B möglicherweise erfahren hatte und die zu einem geringeren Einkommen geführt haben, in dieser Entscheidung auszugleichen.

Wann ist es daher sinnvoll, das Kriterium der demografischen Parität einzusetzen? Unternehmen sollten Proportional Parity als Definition von Fairness verwenden, wenn

- ihnen bewusst ist, dass historische Verzerrungen die Qualität ihrer Daten beeinträchtigt haben könnten,

- sie die benachteiligte Gruppe unterstützen möchten und die Verstärkung historisch gewachsener Nachteile verhindern möchten, oder

- die positive Entscheidung nicht das Risiko birgt, für die Kunden oder das Unternehmen kostspielig zu sein.

Beispiel 2 für Algorithmische Fairness: Equal Opportunity

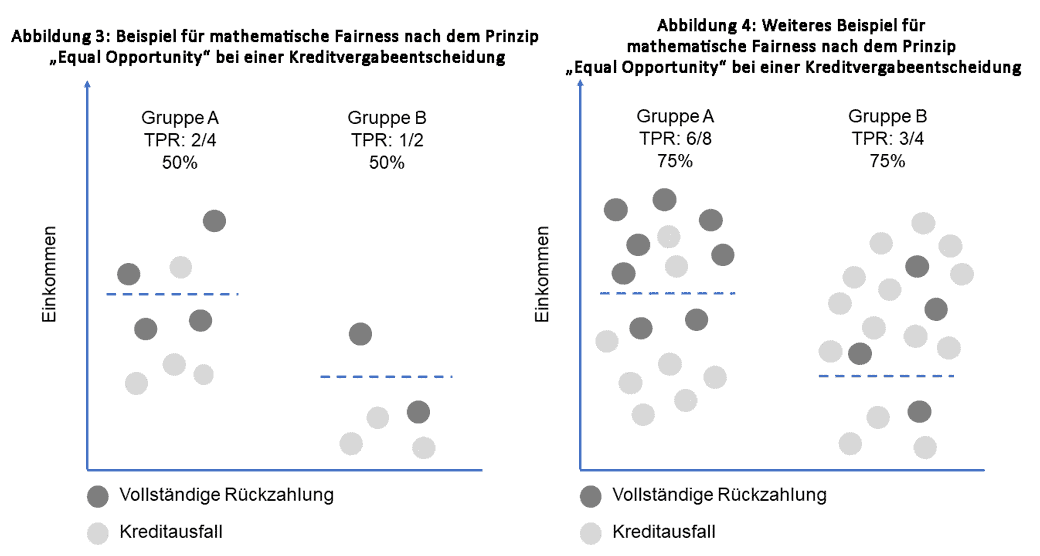

Das zweite betrachtete mathematische Fairness-Kriterium ist das der „Equal Opportunity“. Dieses besagt, dass jede Gruppe das positive Ergebnis zu gleichen Anteilen erhalten sollte – vorausgesetzt, die Personen in dieser Gruppe qualifizieren sich dafür.

Damit liegt diese Definition deutlich näher an den Anforderungen des wirtschaftlichen Handelns wie im Beispiel der Kreditvergabe.”

Equal Opportunity erfordert, dass die positive Entscheidung, also die Kreditzusage, unabhängig von der geschützten Klasse ist – unter der Bedingung, dass es sich tatsächlich um ein positives Ergebnis handelt, der beziehungsweise die Kreditnehmer den Kredit also tatsächlich zurückzahlt. Mathematisch gesprochen bedeutet das die Gleichheit der so genannten „True Positive Rate“ (TPR) für alle betrachteten Gruppen. Resultat ist eine eigene Einkommensschwelle pro Gruppe im betrachteten Beispiel (siehe Abbildung 3), durch die in jeder Gruppe der gleiche Anteil an Personen, die sich bei der Kreditvergabe für einen Kredit qualifizieren, eine Zusage erhält, also in beiden Gruppen jeweils 50 Prozent.

Ist damit für das betrachtete Beispiel die optimale Definition für Fairness geben? Zur Beantwortung dieser Frage lohnt sich ein Blick auf folgende Abbildung, die ein weiteres mögliches Ergebnis darstellt.

Horváth

Wann ist es also sinnvoll, das Kriterium der Equal Opportunity bei der Kreditvergabe einzusetzen? Unternehmen sollten Equal Opportunity als Definition von Fairness verwenden, wenn

- der Schwerpunkt auf der korrekten Vorhersage des positiven Ergebnisses liegt (z. B. betrügerische Aktionen sollen mit sehr hoher Sicherheit erkannt werden),

- die Einführung von True Positiv weder für die Benutzer noch für das Unternehmen kostspielig ist (z. B.: Die falsche Benachrichtigung eines/r Kunden/in über betrügerische Aktivitäten ist weder für die Kunden noch für die Bank, die die Warnung sendet, zwangsläufig teuer), oder

- die Zielvariable nicht als subjektiv angesehen wird (z. B.: Die Einstufung, wer ein/e “gute/r” Mitarbeiter/in ist, führt zu Verzerrungen und ist daher sehr subjektiv).

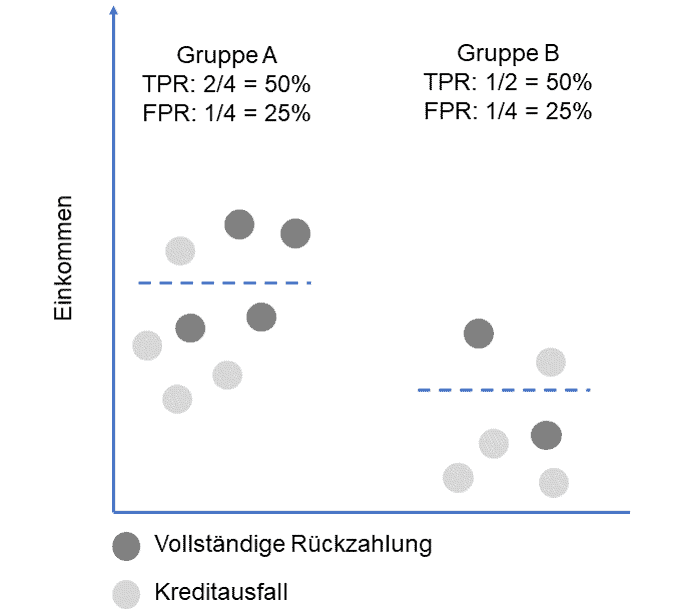

Beispiel 3 für Algorithmische Fairness: Equalized Odds

Die letzte in diesem Beitrag betrachtete Definition von algorithmischer Fairness ist die der „Equalized Odds“. Hierbei handelt es sich um das restriktivste Konzept der bisher besprochenen. Das Kriterium besagt, dass das Modell das positive Ergebnis mit gleichen Raten in allen Gruppen korrekt identifiziert, also wie beim Kriterium Equal Opportunity, jedoch auch das positive Ergebnis in allen Gruppen gleich häufig falsch klassifiziert, um somit den gleichen Anteil an „False Positive“ in allen Gruppen zu erzeugen.

Ein solches Beispiel ist in Abbildung 5 zu sehen. Hier wird das positive Ergebnis mit einer Rate von 50 Prozent für beide Gruppen korrekt identifiziert wird, aber auch der Anteil an „False Positive“ stimmt mit 25 Prozent für beide Gruppen überein.

Horváth

Es ist leicht zu erkennen: Im vorangehenden Beispiel werden bei der Kreditvergabe in Gruppe A weniger Kredite genehmigt, bei denen die vollständige Rückzahlung erwartet wird, um die Gleichheit von TPR und FPR zu garantieren. Durch diese restriktive Fairness-Definition kann die Modellleistung beeinträchtigt werden, da die Genauigkeit für die Mehrheitsgruppe unter diesen Kriterien gegebenenfalls nicht hinreichend optimiert werden kann.

Dies verdeutlicht einen wichtigen Punkt: der existierende Trade-Off zwischen Modell-Genauigkeit und Modell-Fairness. In vielen Fällen kann die Einführung von Fairness-Kriterien zu einem Rückgang an Modell-Genauigkeit führen, da diese eine zusätzliche Modell-Einschränkung bedeuten. Diese Einschränkungen sind jedoch zwingend notwendig, damit algorithmischen Modelle objektive Entscheidungen ohne Bias treffen.

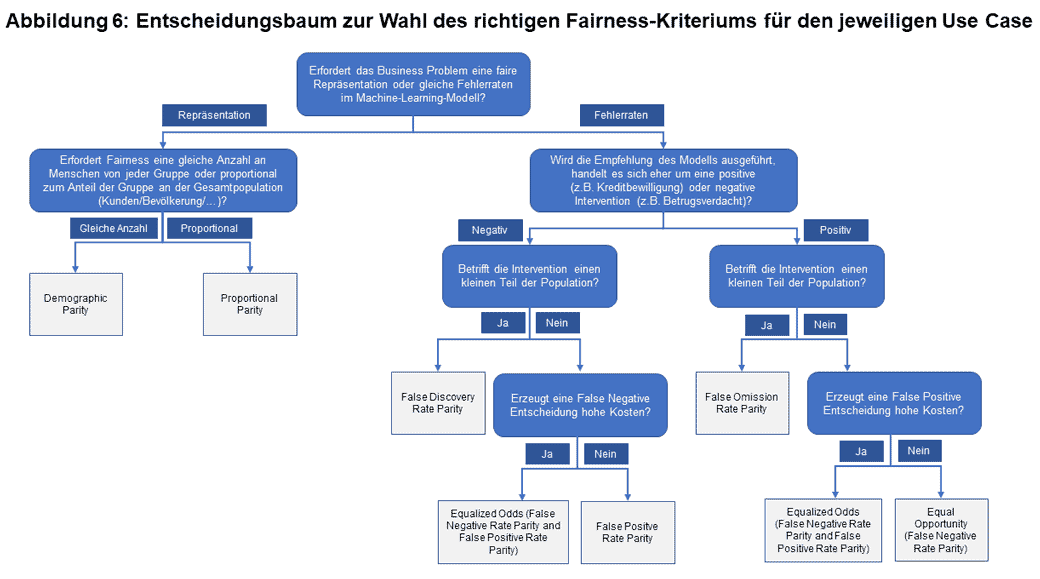

Das Kreditentscheidungsbeispiel zeigt, dass für ein und dieselbe Fragestellung verschiedene Fairness-Kriterien in Frage kommen können. Die Wahl des jeweiligen Kriteriums, nach dem die Fairness eines Models gemessen werden soll, ist stark Business-Kontext abhängig. Der folgende Entscheidungsbaum (Abbildung 6) kann als Hilfe zur Wahl des richtigen Fairness-Kriteriums für den jeweiligen Use Case zu Rate gezogen werden:

datasciencepublicpolicy

Fairness in Kreditvergabe-Algorithmen optimieren

Um die Fairness von Algorithmen im Rahmen der vorgestellten Definitionen nun noch zu optimieren, gibt es zum einen technische Möglichkeiten, zum anderen organisatorische Hebel.

Technische Möglichkeiten zur Bias-Reduzierung in Algorithmen bestehen im Wesentlichen aus den folgenden drei Schritten einer klassischen Machine-Learning-Pipeline:

- Pre-processing: Transformation der Daten vor dem Modell Training

- In-processing: Adjustierung des Modells während des Trainings

- Post-processing: Anpassen der Modellergebnisse nach dem Training

Auch in der Unternehmensorganisation gibt es wichtige Hebel zur Fairness-Sensibilisierung, die bereits vor der eigentlichen Lösungsentwicklung den Weg für diskriminierungsfreie Algorithmen ebnen, nämlich:

– Stakeholder identifizieren

– Bewusstsein schärfen

– Business-Kontext-spezifische Fairness-Definition festlegen

– Einführung eines Audit-Prozesses für algorithmische Lösungen

– Forschung und Regulatorik aufmerksam verfolgen

Die daraus resultierenden Leitlinien für die Kreditvergabe sollten in Form eines sogenannten „Bias Impact Statements“ zum integralen Bestandteil algorithmischer Lösungsentwicklungen gemacht werden. Die Prinzipien können je nach Anforderung der Organisation angepasst werden, sollten aber für alle Entwicklungsprozesse einheitlich sein und stringent befolgt werden. Auf diese Weise stellt ein Unternehmen seinen verantwortungsvollen Umgang mit von Algorithmen erstellten Entscheidungsvorlagen beziehungsweise voll-automatisierten Entscheidungen sicher.Benjamin Grether, Horváth

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/127418

Schreiben Sie einen Kommentar