Tickende Zeitbombe: Warum Large Language Models ohne Sicherheitskonzept zum Risiko werden

aDvens

von Matthias Bissinger, Senior Security Consultant bei aDvens

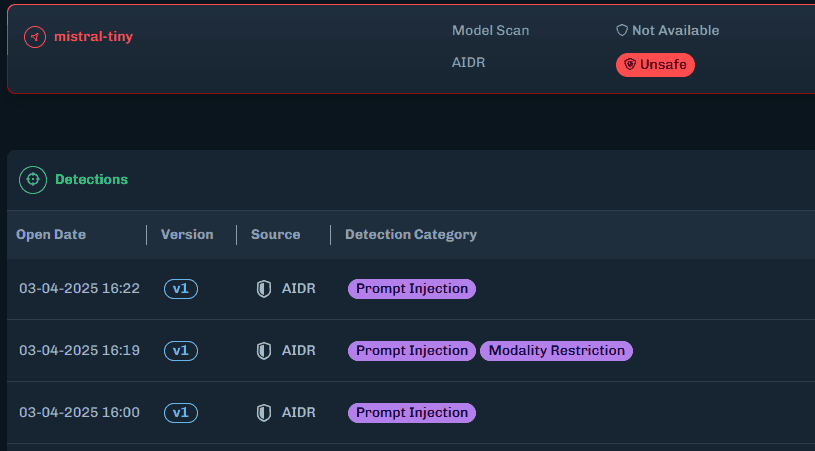

LLMs sind anfällig für verschiedene Angriffsszenarien.Ein klassischer Angriff sind Prompt Injections, bei denen manipulierte Eingaben das Sprachmodell zu unerwünschten oder schädlichen Ausgaben verleiten können.“

Ebenso kritisch ist Data Leakage, wobei vertrauliche Informationen aus Trainings- oder Nutzerdaten unbeabsichtigt preisgegeben werden. Darüber hinaus besteht die Gefahr der Model Inversion, bei der Angreifer durch geschickte Abfragen potenziell Teile der Trainingsdaten rekonstruieren können. Auch Adversarial Attacks stellen eine Bedrohung dar: Durch eine gezielte Modifikation von Eingaben kann das Modell manipuliert werden, um „falsche“ Antworten zu liefern. Zudem besteht immer das Risiko von Bias und Halluzinationen, die zu voreingenommenen oder fehlerhaften Antworten führen können – eine Herausforderung, die besonders in der Finanzbranche schwerwiegende Konsequenzen haben kann.

Sicheres Deployment von LLMs

Um LLMs in Finanzumgebungen sicher betreiben zu können, sind gezielte Sicherheitsmaßnahmen unumgänglich. Hierzu gehören unter anderem eine abgesicherte Umgebung mit strikten Zugriffskontrollen, eine konsequente Überwachung der Eingaben sowie Maßnahmen zur Überwachung und schnellen Reaktion auf sicherheitskritische Vorfälle.

Isolierung und Zugriffskontrolle

Der Einsatz von Container-Umgebungen wie Docker oder Kubernetes hilft dabei, Modelle voneinander zu isolieren und eine klare Trennung zwischen verschiedenen LLM-Instanzen sicherzustellen.“

Zusätzlich sollte der Zugriff auf die Modelle streng reguliert werden, beispielsweise durch Role-based Access Control (RBAC) und Multi-Faktor-Authentifizierung (MFA). Netzwerksegmentierung als weitere Schutzmaßnahme stellt sicher, dass unautorisierte Kommunikation zwischen LLM-Instanzen und anderen Systemen verhindert wird.

Eingabe-Validierung und Filterung der LLMs

Wichtig ist außerdem die Prompt Sanitization.“

Bei dieser wird jede Eingabe auf schädliche oder unerwartete Inhalte geprüft, vergleichbar zur Input Sanitization bei Datenbankabfragen zur Vermeidung von SQL Injections. Darüber hinaus kann ein Rate-Limiting implementiert werden, um zu verhindern, dass Angreifer das LLM mit einer hohen Anzahl von Anfragen überlasten (Denial of Service). Eine weitere Maßnahme besteht darin, über White- oder Blacklisting bestimmte Begriffe zu filtern und so potenzielle Risiken zu minimieren.

Logging, Monitoring und Incident Response

Zur Überwachung der Modellaktivitäten sollte ein Security Information and Event Management (SIEM) eingesetzt werden.“

Diese Systeme ermöglichen eine Echtzeit-Analyse der Modellinteraktionen und helfen, verdächtige Anfragen frühzeitig zu erkennen. Mittlerweile hat sich auch hierfür ein Markt gebildet, der dedizierte Tools zur Erkennung von Angriffen auf LLMs entwickelt und anbietet. Ergänzend kann Machine Learning zur Anomalieerkennung genutzt werden, um ungewöhnliche Nutzungsmuster zu identifizieren.

Falls sicherheitskritische Vorfälle auftreten, sollten – im besten Fall automatisierte – Eskalationsmechanismen vorhanden sein, die eine schnelle Reaktion ermöglichen.“

aDvens

Datenschutz und Compliance

Falls LLMs mit sensiblen Finanzdaten arbeiten, ist die Einhaltung regulatorischer Vorgaben unerlässlich.

Unternehmen sollten den Grundsatz der Datensparsamkeit befolgen, indem sie die unnötige Speicherung von Nutzereingaben oder Modellantworten vermeiden.“

Ebenso muss eine durchgehende Ende-zu-Ende-Verschlüsselung sichergestellt werden, sowohl während der Übertragung als auch bei der Speicherung sensibler Daten. Zur Reduzierung externer Datenschutzrisiken kann der Einsatz von On-Premise-Hosting sinnvoll sein. Alternativ bietet sich Federated Learning als Methode an, um Trainingsdaten dezentral zu halten und das Risiko zentralisierter Datenlecks zu minimieren. Zusätzlich sind Audit-Logs erforderlich, um sämtliche Interaktionen mit dem Modell nachvollziehbar zu machen. Penetrationstests helfen dabei, Schwachstellen in der Implementierung frühzeitig zu erkennen und zu schließen.

Matthias Bissinger ist Senior Security Consultant bei aDvens (Website) und Master of Science in Digitaler Forensik. Zuvor war er zehn Jahre als Software-Entwickler im militärischen Sektor und sechs Jahre als Lead Security Analyst und als Head of Cybersecurity Operations Center Central Europe bei einem europaweit agierenden Cybersecurity-Dienstleister tätig. Sein Fokus liegt im Bereich Security Operations, Breach-and-Attack-Simulation, Security Architecture sowie Red- und Purple-Teaming.

Matthias Bissinger ist Senior Security Consultant bei aDvens (Website) und Master of Science in Digitaler Forensik. Zuvor war er zehn Jahre als Software-Entwickler im militärischen Sektor und sechs Jahre als Lead Security Analyst und als Head of Cybersecurity Operations Center Central Europe bei einem europaweit agierenden Cybersecurity-Dienstleister tätig. Sein Fokus liegt im Bereich Security Operations, Breach-and-Attack-Simulation, Security Architecture sowie Red- und Purple-Teaming.Modell-Absicherung gegen Manipulation

Neben Angriffen auf die Eingaben müssen auch die LLMs selbst geschützt werden.

Eine zentrale Maßnahme zur Sicherung der Integrität ist die Nutzung digitaler Signaturen sowie regelmäßige Checksummen-Prüfungen, um unautorisierte Änderungen am Modell zu verhindern.“

Zudem kann durch Wasserzeichen sichergestellt werden, dass von LLM generierte Texte als solche identifizierbar bleiben. Unternehmen sollten außerdem regelmäßige Red-Teamings durchführen, bei denen simulierte Angriffe dazu genutzt werden, potenzielle Schwachstellen frühzeitig zu identifizieren. Ein weiterer wichtiger Aspekt ist die kontinuierliche Anpassung der Modelle durch dynamische Modell-Updates, um Sicherheitslücken zu schließen und Bias zu reduzieren.

Zukunftsperspektiven und Fazit

Die Sicherheitslandschaft für LLMs entwickelt sich rasant.

Fortschritte in Differential Privacy, Zero-Trust-Architekturen und homomorpher Verschlüsselung könnten künftig neue Schutzmaßnahmen ermöglichen.“

Dennoch bleibt der sichere Einsatz von LLMs in der Finanzbranche eine Herausforderung, die ein mehrschichtiges Sicherheitskonzept erfordert. Unternehmen sollten gezielt Maßnahmen zur Eingabevalidierung, zum Datenschutz und der Modellabsicherung implementieren und ihre Systeme regelmäßig auf neue Bedrohungen prüfen. Nur durch ein bewusstes Risikomanagement können LLMs sicher und effektiv in geschäftskritischen Prozessen eingesetzt werden.Matthias Bissinger, aDvens

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/226203

Schreiben Sie einen Kommentar