Grid-to-Chip statt 230 Volt: Wie modulare Rechenzentren die KI-Revolution stemmen werden

Noris Network

von Florian Sippel, Vorstand und COO, Noris Network

Noch vor wenigen Jahren galten hochverfügbare VK4-Rechenzentren als das Nonplusultra der Ingenieurskunst im IT-Sektor. Doch die „Explosion der Intelligenz“, wie Nvidia-CEO Jensen Huang den aktuellen Umbruch sinngemäß beschreibt, zwingt die Branche zu einem grundlegenden Umdenken.

Die Anforderungen durch KI-Anwendungen sprengen zunehmend die Grenzen konventioneller Infrastruktur – insbesondere bei Stromversorgung und Kühlung.“

Vor diesem Hintergrund entwickeln sich modulare Rechenzentren von einer konzeptionellen Idee zur praxistauglichen Antwort auf die exponentiell wachsenden Anforderungen des Marktes.

Grid to Chip: Energieversorgung wird zur Herausforderung

Florian Sippel ist Vorstand und Chief Operating Officer (COO) der noris network AG (Website) und verantwortet dort die strategische Entwicklung moderner Rechenzentrumsinfrastrukturen. Mit mehr als zwei Jahrzehnten Erfahrung in der IT- und Rechenzentrumsbranche gilt er als technischer Vordenker für hochverfügbare, modulare und nachhaltige IT-Infrastrukturen in Deutschland. Er ist Co-Autor mehrerer Fachpublikationen zum Thema Rechenzentrumsplanung und -betrieb und setzt sich aktiv für die Standardisierung von Technologien rund um Hochleistungsrechnen, Edge Computing und KI-Infrastruktur ein.

Florian Sippel ist Vorstand und Chief Operating Officer (COO) der noris network AG (Website) und verantwortet dort die strategische Entwicklung moderner Rechenzentrumsinfrastrukturen. Mit mehr als zwei Jahrzehnten Erfahrung in der IT- und Rechenzentrumsbranche gilt er als technischer Vordenker für hochverfügbare, modulare und nachhaltige IT-Infrastrukturen in Deutschland. Er ist Co-Autor mehrerer Fachpublikationen zum Thema Rechenzentrumsplanung und -betrieb und setzt sich aktiv für die Standardisierung von Technologien rund um Hochleistungsrechnen, Edge Computing und KI-Infrastruktur ein.Gerade bei hohen Strömen führt der Energieverlust durch ohmschen Widerstand (I²R) zu erheblichen thermischen Problemen. Kupferleitungen müssen mit zunehmender Stromstärke massiv dimensioniert werden und führen so zur technischen und wirtschaftlichen Belastung. Wie drastisch die Entwicklung ist, brachte kürzlich ein Techniker auf dem Datacloud Global Congress 2025 in Cannes auf den Punkt, als NVIDIA das Referenzdesign der nächsten GPU-Generation vorstellte:

Wenn die Kupferkabel dicker als dein Unterarm sind, hast du ein Problem.“

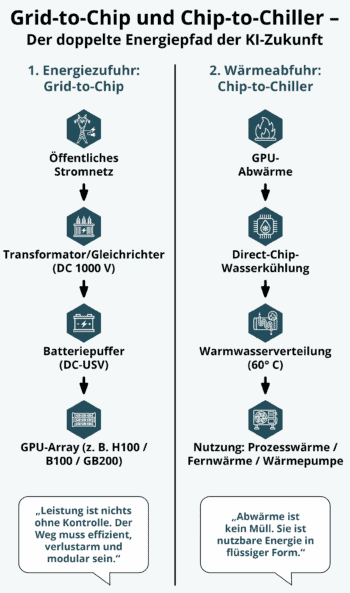

Die Lösung: eine Hochvolt-Gleichstromversorgung (HVDC) direkt ins Rack – typischerweise mit 800 bis 1000 V DC – gespeist aus einem intelligenten DC-Grid. Dieses Konzept reduziert Leitungsverluste signifikant, ermöglicht kleinere Leitungsquerschnitte, integriert Pufferbatterien effizienter und vereinfacht Redundanzkonzepte durch segmentierte, modulare Architektur.

Das Ziel ist klar: eine verlustarme, direkte Energieversorgung vom Netzanschlusspunkt bis zur GPU – „Grid to Chip“ – mit minimalen Umwandlungsschritten, maximaler Effizienz und hoher Lastflexibilität.“

Einige Hersteller entwickeln bereits HVDC-Lösungen mit mehr als 90 % Effizienz, NVIDIA prognostiziert 5 % Effizienzgewinn beim Umstieg auf 800 V. Zunehmend zeigt sich aber auch: Der Flaschenhals ist nicht nur die Stromverteilung – sondern die Stromverfügbarkeit selbst. Projekte mit 50 MW Leistung erfordern heute Strommengen, die mit denen ganzer Städte vergleichbar sind. Lange Realisierungszeiten für Netzanschlüsse treiben die Nachfrage nach „powered land“ und Onsite-Erzeugung, etwa durch Gasturbinen.

Noris Network

Chip to Chiller: Neue Wertigkeit für Abwärme

Nicht weniger transformativ ist der zweite Energiepfad: die Wärme. Luftkühlung stößt nicht erst seit gestern an ihre physikalischen Grenzen. GPU-Arrays mit 400 kW und mehr erzeugen Wärmeströme, die konventionelle Lösungen überfordern. Die Konsequenz ist eine Umstellung auf Direct-to-Chip-Wasserkühlung. 2024 machen solche Flüssigkühlmethoden bereits über 68 % des schnell wachsenden Marktes für Rechenzentrumskühlung aus – mit einem erwarteten Volumen von fast 18 Milliarden US-Dollar (ca. 15,6 Milliarden Euro) bis 2030.

Dabei entstehen Rücklauftemperaturen von bis zu 60°C, was nicht nur eine effizientere Wärmeabfuhr erlaubt, sondern auch die thermodynamische Möglichkeit schafft, industrielle Prozesswärme bereitzustellen. Anders ausgedrückt: Was früher reine Verlustleistung war, wird heute zum Asset. Wärmepumpen, die bisher zwischen 30°C und 35°C Vorlauf aus der Abwärme bekamen, können jetzt aufgrund der deutlich höheren Temperaturen mit einem besserem COP arbeiten.

Große Hyperscaler wie Microsoft setzen Abwärme heute bereits in Fernwärmenetzen ein – ein Konzept, das vom Open Compute Project (OCP) standardisiert wird.“

Entwicklungen, die verdeutlichen: HVDC-Stromversorgung und Flüssigkühlung sind eng miteinander verbunden.

Die Modularisierung: Antwort auf die Unplanbarkeit

Eine der weitreichendsten Folgen des KI-Zeitalters bleibt zweifelsohne die zunehmende Unplanbarkeit technologischer Anforderungen. Während früher Investitionszyklen von zehn Jahren üblich waren, liegt der Planungshorizont heute oft nur noch bei zwei Jahren. Technologien, die heute als hochmodern gelten, können morgen bereits überholt sein. Diese Dynamik verändert grundlegend, wie Rechenzentren gebaut und betrieben werden. Statt langfristig festgelegter Infrastrukturkonzepte gewinnt Modularität an zentraler Bedeutung. Modulare Rechenzentren ermöglichen es, Investitionen schrittweise und bedarfsgerecht zu tätigen. Sie bieten die nötige Flexibilität, um auf technologische Entwicklungen kurzfristig reagieren zu können.

Dabei folgt das Konzept einem klaren Prinzip: Infrastruktur wird nur dort errichtet, wo sie tatsächlich gebraucht wird. GPU-Cluster lassen sich als voneinander unabhängige Einheiten realisieren – autark, austauschbar, rekonfigurierbar und skalierbar. In China etwa setzen Unternehmen wie Alibaba diesen Ansatz bereits konsequent um. Im Zweijahresrhythmus werden dort komplette IT-Container durch neue ersetzt. Deren CUBE DC 5.0-Systeme sind vollständig modular konzipiert und verkürzen laut Herstellerangaben die Bereitstellungszeit um 50 %. Auch in Europa ist dieser Trend erkennbar. Der Schlüssel liegt in einem neuen Lebenszyklusmodell: Gebäude und Basisinfrastruktur haben eine Nutzungsdauer von 15 bis 20 Jahren, während KI-Racks alle zwei bis vier Jahre ersetzt werden müssen. Rechenzentren werden damit zu flexiblen Hüllen mit austauschbaren Motoren.

Fehlende Standards führen zu technologischer Fragmentierung

Doch mit der zunehmenden Modularität gehen neue Herausforderungen einher. Zwar wächst das Angebot an modularen Komponenten, doch die Branche arbeitet bislang ohne einheitliche Standards. Stromstecker, Wasserkupplungen oder Steuerungssysteme für Pumpen – der Markt ist stark fragmentiert. Und obgleich sich erste herstellerübergreifende Lösungen etablieren, etwa der Danfoss-Stecker bei Wasserkupplungen, ist ein branchenweiter De-facto-Standard noch nicht in Sicht:

Während beispielsweise das Open Compute Project aktiv daran arbeitet, offene Schnittstellen für Strom, Kühlung und Management zu standardisieren, bauen Anbieter wie Dell, NVIDIA oder HPE weiter auf proprietäre, vertikal integrierte Systeme.“

Diese sind leistungsfähig – aber selten interoperabel. Was also fehlt, ist der „USB-Stecker für Rechenzentren“; eine durchgängige Schnittstelle, die Kompatibilität und Integration vereinfacht. Für Enterprise-Kunden bedeutet das einen hohen Integrationsaufwand, insbesondere beim Zusammenspiel verschiedener Systeme.

Skalierung vs. Dezentralisierung: Der Energiekompromiss

In der Stromversorgung wiederum konkurrieren zwei Modelle miteinander: das zentralisierte Hyperscale-Modell mit Multimegawatt-Infrastruktur und das dezentrale modulare Modell mit Einbindung in regionale Stromnetze. Das eine verspricht „economies of scale“, das andere Resilienz und Flexibilität. Dabei entsteht kein Entweder-oder, sondern ein hybrides „Hub-and-Spoke“-Modell: Zentrale „AI-Factories“ für rechenintensives Training, vernetzt mit dezentralen Edge-Zentren für Inferenz in Nutzernähe.

Dieses Modell bietet Resilienz, Energieeffizienz und geopolitische Souveränität – denn KI-Infrastruktur wird zunehmend als strategisches Asset bewertet, nicht nur als Betriebsmittel.“

Die Explosion der Leistungsdichte, die geopolitische Bedeutung von KI-Infrastruktur und der Bedarf nach modularer Flexibilität zeigen: Der Wandel ist nicht optional – er ist längst Realität. Wer heute ein Rechenzentrum für KI-Anwendungen plant, steht vor der Wahl zwischen Skalierbarkeit und Stagnation. Die Antwort liegt in modularer, hochspezialisierter Infrastruktur, die genau dann bereitsteht, wenn sie gebraucht wird. Oder um es mit einem alten Ingenieursmotto zu sagen: „Was man nicht vereinfachen kann, hat man nicht verstanden.“ Florian Sippel, Noris Network

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/229223

Schreiben Sie einen Kommentar