Blindflug im Rechenzentrum: Weshalb fast alle Finanzinstitute die Kontrolle über ihre KI-Modelle verlieren

Fico

von Dr. Scott Zoldi, Chief Analytics Officer Fico

Die gemeinsame Studie von Corinium und Fico zeichnet ein Bild, das in einem streng regulierten Sektor kaum vorstellbar scheint. Lediglich sieben Prozent der IT-Verantwortlichen geben an, ihre KI-Modelle vollständig zu überwachen. Das bedeutet im Umkehrschluss, dass in über neunzig Prozent der Institute KI-Anwendungen nach der Inbetriebnahme ohne systematische Kontrolle laufen.Es fehlen Warnsysteme für schleichende Datenabweichungen, stabile Leistungskennzahlen und definierte Metriken mit Schwellenwerten, um ein KI-Modell bei Bedarf abzuschalten.“

Außerdem gibt es meist keine automatisierte Nachvollziehbarkeit für die interne Revision oder Bankenaufsicht, die belegt, dass KI verantwortungsvoll und wie beabsichtigt eingesetzt wird.

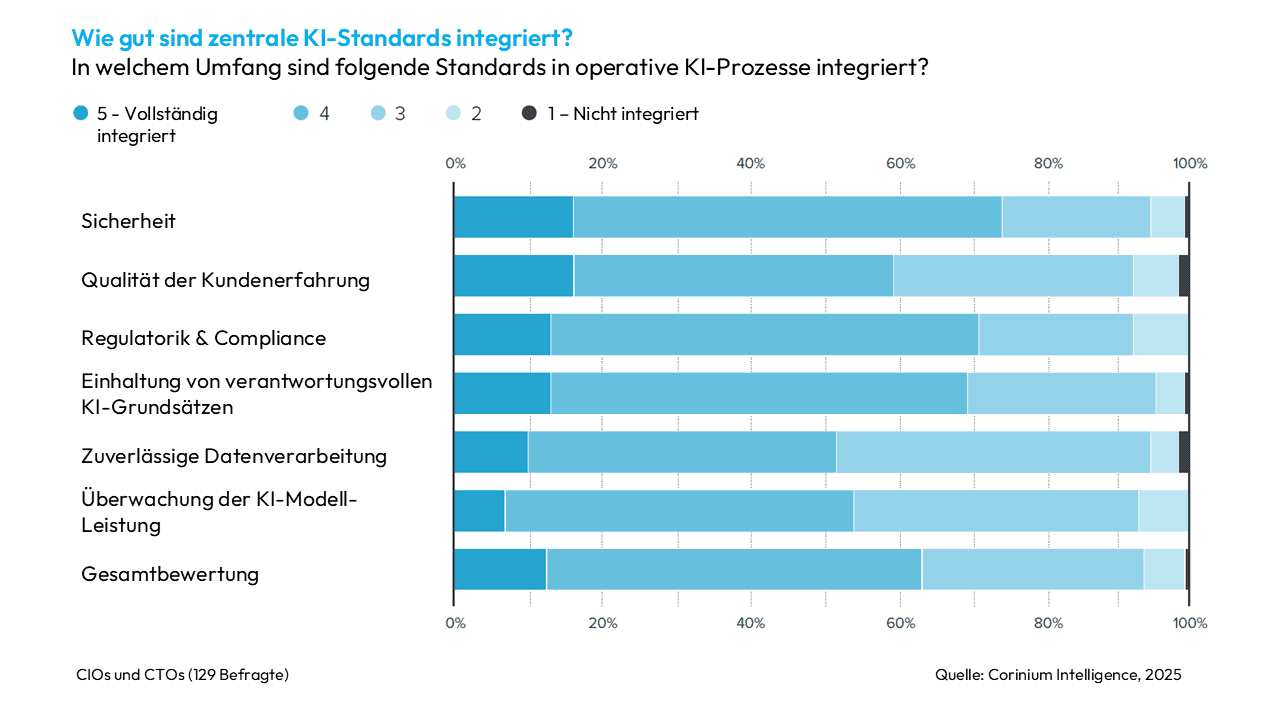

Hier offenbart sich eine gefährliche Schieflage der Prioritäten. Zwar sind Sicherheitsstandards in immerhin 16 Prozent der Häuser vollständig umgesetzt, für die Modellüberwachung gilt dies aber nur in besagten sieben Prozent. Viele Banken installieren also Alarmanlagen für ihre Gebäude, lassen KI-Software darin jedoch unbeobachtet laufen. Wer aber nicht prüft, wie KI-Modelle Daten verarbeiten, schätzt das Risikoprofil grundlegend falsch ein.

Fico

KI-Modelle, die über Kreditrahmen entscheiden, Transaktionen klassifizieren oder Betrug erkennen sollen, sollten ohne operative Unsicherheit betrieben werden. Ein solches Unsicherheitsniveau wäre in einem Kernbankensystem nicht akzeptabel. Doch die KI-Modelle bleiben fragmentiert, manuell gepflegt und damit ineffizient. Zudem wissen die meisten Organisationen nicht, wie KI-Systeme angemessen überwacht werden sollen. Sie verfügen weder über KI-Blockchains noch über andere Mechanismen, um die Überwachung und Kontrolle von KI im produktiven Einsatz zu definieren.

Dr. Scott Zoldi ist Chief Analytics Officer bei Fico (Website), wo er seit über 24 Jahren tätig ist und die Entwicklung von Advanced Analytics und KI-Technologien verantwortet. Zuvor kam er über HNC Software zu FICO und leitete dort Teams in den Bereichen Betrugserkennung, Kreditrisiko, Cybersicherheit und Echtzeit-Entscheidungssysteme. Er promovierte in theoretischer und computergestützter Physik an der Duke University.

Dr. Scott Zoldi ist Chief Analytics Officer bei Fico (Website), wo er seit über 24 Jahren tätig ist und die Entwicklung von Advanced Analytics und KI-Technologien verantwortet. Zuvor kam er über HNC Software zu FICO und leitete dort Teams in den Bereichen Betrugserkennung, Kreditrisiko, Cybersicherheit und Echtzeit-Entscheidungssysteme. Er promovierte in theoretischer und computergestützter Physik an der Duke University.KI-Infrastruktur scheitert an der Realität

Der zweite Befund ist ebenfalls alarmierend:

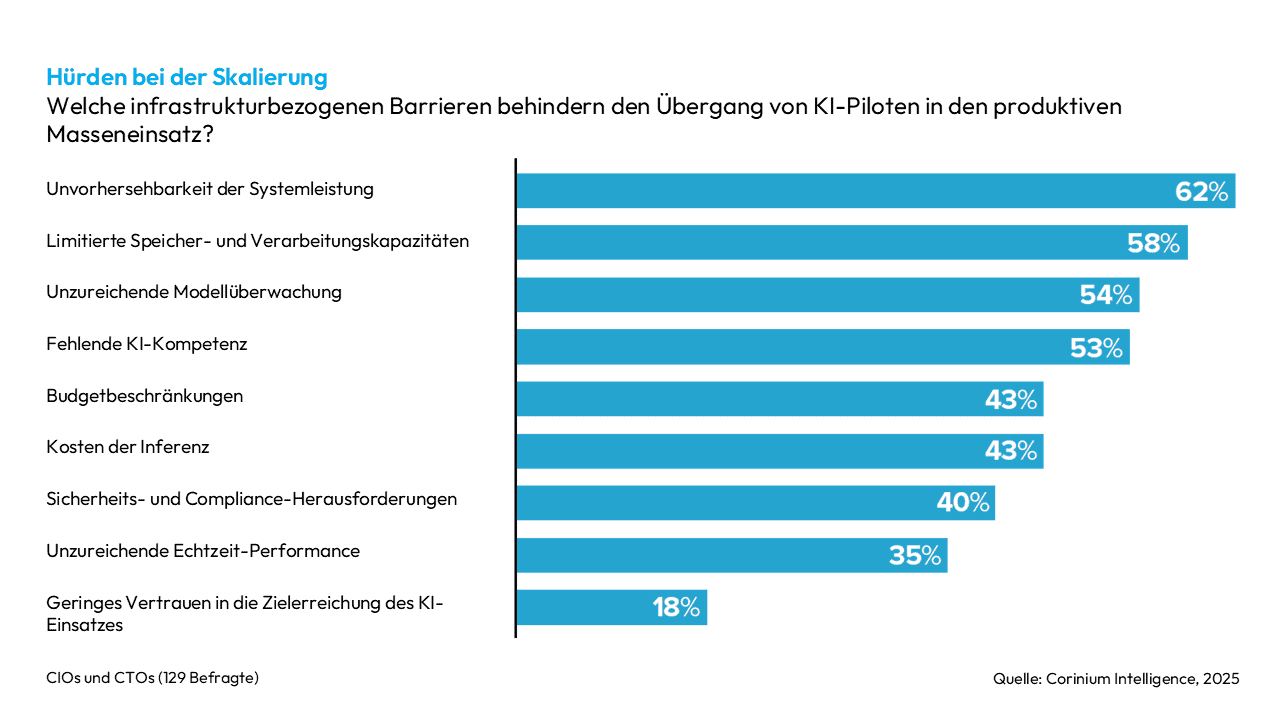

Hauptprobleme sind dabei weder Kosten noch Speicherplatz oder Rechenkapazität, sondern schlicht die Unsicherheit über die Softwarestabilität und die vorhersehbare Operationalisierung von KI. Über die Hälfte der Befragten kämpft mit begrenzten Ressourcen bei der Verarbeitung, und rund ein Drittel ist technisch nicht in der Lage, eine Überwachung in Echtzeit zu etablieren.Fast zwei Drittel der Chief Technology Officers (CTOs) nennen die Unvorhersehbarkeit der Systemleistung als größte Hürde für Wachstum.“

So entsteht eine Diskrepanz zwischen der Euphorie über Künstliche Intelligenz und der technischen Wirklichkeit. Viele Institute modernisieren zwar ihre Anwendungslandschaft, doch das Fundament ist für die neuen Lasten nicht ausgelegt. KI-Modelle haben spezialisierte Anforderungen an Daten, Daten-Orchestrierung, Latenz, Durchsatz und Observability (technische Beobachtbarkeit), um die operative Stabilität zu gewährleisten.

Ohne eine laufende Kontrolle fliegt eine Bank im Blindflug, sobald sich die Realität verändert – und die Systeme ausfallen.“

Fico

Erschwerend kommt hinzu, dass die meisten Häuser ihre Modelle isoliert einsetzen, mit unterschiedlichen KI-Tools arbeiten und ohne gemeinsame technische Basis betreiben. Das erhöht die Komplexität, um konsistente Zuverlässigkeit und die Operationalisierung von KI sicherzustellen. Zwar löst jede Abteilung ihr eigenen Probleme, verlangsamt damit aber die Fähigkeit, den Einsatz von KI effektiv zu skalieren. Für die IT bedeutet das, dass das Gesamtsystem unbeherrschbar bleibt, selbst wenn einzelne Teams gute Arbeit leisten.

Wenn KI-Teams isoliert arbeiten

Diese technische Fragmentierung hat oft organisatorische Ursachen. Der Bericht deckt auf, dass lediglich rund fünf Prozent der Finanzinstitute eine hohe Übereinstimmung zwischen den Zielen des Geschäftsbetriebs und der KI-Strategie erreichen. Für die IT hat das zur Folge, dass Modelle häufig gebaut werden, ohne vorab zu prüfen, ob die Infrastruktur diese langfristig tragen kann. Gleichzeitig wird die Technik modernisiert, ohne zu verstehen, welche KI-Anwendungen in Zukunft darauf laufen sollen. Oft werden dabei die operativen Anforderungen für die Ausführung dieser KI-Modelle und -Anwendungen weder verstanden noch festgelegt.

Verschärft wird das Problem durch die fehlende KI-Kompetenz in den Fachbereichen, was 65 Prozent der Befragten als zentrale Wachstumsbremse nennen. Was zunächst nach einem weichen Faktor klingt, ist ein hartes technisches Problem.

Ohne ein gemeinsames Verständnis entstehen inkompatible Messgrößen, widersprüchliche Prüfpfade und Risikobewertungen, die sich nicht vergleichen lassen. Das ist nicht nur operativ ineffizient, sondern auch regulatorisch nicht darstellbar.“

Der Weg aus dem Chaos: Standards durch integrative Plattformtechnologie statt manueller Prozesse

Die Studie liefert zugleich die Lösung für dieses Dilemma. Mehr als die Hälfte der Führungskräfte geht davon aus, dass eine gemeinsame KI-Plattform die Rentabilität um mindestens fünfzig Prozent erhöhen würde, während ein Viertel sogar eine Verdoppelung erwartet. Diese Erwartung ist technisch begründet, da eine gemeinsame Plattform einheitliche Verarbeitungswege schafft, die automatische Kontrollpunkte sowie die Anforderungen an eine konsistente System-Observability und KI-Modellüberwachung ermöglichen.

Sobald die Messung von Abweichungen, die Analyse von Verzerrungen, Versionierung, Prüfpfade, Software-System-Observability und Leistungsmessung technisch integriert sind, entsteht erstmals ein durchgehender Lebenszyklus, der auch den regulatorischen Anforderungen standhält. Standards werden in diesem Szenario nicht mehr nur definiert, sondern fest implementiert, was die einzig wirksame Form der Standardisierung darstellt.

Diese konsolidierte technische Basis ermöglicht standardisierte und eingebettete Überwachungsfunktionen für alle Modelle sowie gleiche Qualitätsmaßstäbe. Sie stellt ein sauberes Software-Design und die Observability der Systemausführung sicher. Sie sorgt für sofortige Reproduzierbarkeit, einheitliche Risikoindikatoren und eine Governance, die maschinenlesbar ist. Banken und Versicherer gewinnen dadurch nicht nur an Stabilität, sondern auch an Geschwindigkeit. Modelle können schneller in Betrieb gehen, da alle Freigaben, Prüfpfade und Überwachungsmechanismen bereits existieren. Damit entsteht jene Skalierbarkeit, die bisher oft nur diskutiert wurde.

Das Ende der KI-Experimente

Banken und Versicherer betreiben heute KI-Modelle, die einen strategischen Einfluss auf Betrugserkennung, Risiken, Erträge sowie Innovation und Wachstum haben. Die Infrastruktur dahinter gleicht jedoch viel zu oft noch einer Versuchsanordnung.“

Diese Diskrepanz führt direkt zu unvorhersehbarer Software-Systemleistung, fehlender Kontrolle und Entscheidungen, die sich weder erklären noch verantworten lassen.

Der technische Auftrag ist daher eindeutig:

KI gehört fest in die IT-Architektur integriert und ist keine Experimentierwerkstatt.“

Die Modell-Überwachung muss automatisch stattfinden statt manuell, und Standards müssen im Programmcode verankert sein statt in PDF-Dokumenten. Nur ein guter Plattform-Ansatz führt KI-Modelle hierfür zusammen, statt sie zu trennen, und beinhaltet ein vollständig kohärentes Set an Anforderungen zur KI-Operationalisierung- einschließlich Observability und Überwachung der KI-Software-Ausführung. Solange dieser Wandel nicht vollzogen wird, verharrt die Branche im Blindflug. Leider ist dieser Blindflug kein theoretisches Risiko, sondern tägliche Realität.Dr. Scott Zoldi, Fico /aj

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/238627

Schreiben Sie einen Kommentar