BCBS 239 macht effizient, transparent & krisenfest

BCBS 239 kann zu Effizienzgewinnen führen. Außerdem können Banken bei erfolgreicher Umsetzung der Anforderungen die finanziellen Folgen von Krisensituationen deutlich schneller und besser erfassen als bisher. Doch die Grundlagen stimmen noch nicht überall. Gerade die Datenqualität lässt in vielen Kreditinstituten noch zu wünschen übrig. Das zeigt die Studie „Auswirkungen des BCBS 239 Grundsätze zur Aggregation von Risikodaten und Risikoberichterstattung auf deutsche Kreditinstitute“.

von Christoph Prellwitz und Markus Nicklas, msgGillardon

Die Risikomanagement-Richtlinie BCBS 239 richtet sich in erster Linie an global systemrelevante Institute, von denen es in Deutschland nur eines gibt – die Deutsche Bank. Trotzdem sollten große und mittlere deutsche Banken das Thema nicht einfach beiseiteschieben. Denn die „Grundsätze zur Aggregation von Risikodaten und Risikoberichterstattung“ werden in die Novelle der MaRisk eingebettet und gelten dann künftig für alle Geldhäuser.Darüber hinaus verbergen sich hinter BCBS 239 für die Kreditinstitute nicht nur erheblicher Aufwand, sondern auch große Chancen.“

Christoph Prellwitz, msgGillardon

Denn die Richtlinie zielt darauf ab, die internen Prozesse zu verbessern, zum Beispiel bei der Datenaggregation und dem Berichtswesen. Das führt zu langfristigen Effizienzgewinnen. Außerdem können Banken die finanziellen Folgen von Krisensituationen deutlich schneller und besser erfassen als bisher.

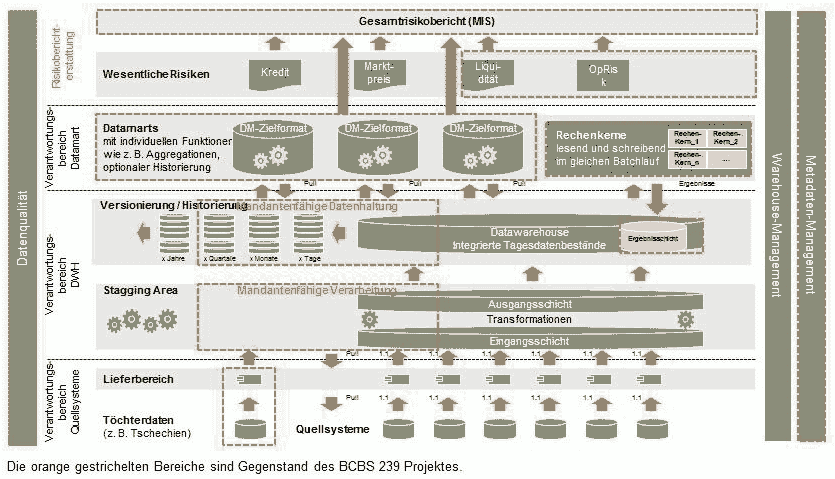

BCBS 239 stellt erstmals auch konkrete regulatorische Ansprüche an die IT-Architektur und das Datenmanagement in Kreditinstituten und hat hohe Forderungen an die Erfassung und Verarbeitung risikorelevanter Daten. Dabei müssen sich Banken auf drei Aufgabengebiete konzentrieren, die sich auch gegenseitig beeinflussen. Es handelt sich dabei um Datenqualität, Data Governance und Datenmanagement.

Die Grundlage jeder Unternehmensentscheidung: Richtige Daten

Um strategisch zu arbeiten und Entscheidungen zu treffen, benötigt das Management einer Bank vor allem hochwertige und richtige Daten. Doch einzelne Maßnahmen und Insellösungen bringen oft nicht den erhofften Durchblick. Darum setzt die Aufsicht das Thema besonders hoch auf die Agenda der Banken. Zudem regelt sie in den BCBS 239 Datenqualitätsaspekte gleich an mehreren Stellen innerhalb der Prinzipien. Im Rahmen des ersten Prinzips Governance legen die Gesetzgeber die Datenqualität im Risikomanagement in den Verantwortungsbereich der Geschäftsleitung und bestimmen, dass die Einhaltung über alle Institutsgruppen und IT-Systemgrenzen hinweg gewährleistet sein muss. Im zweiten Prinzip zur Datenarchitektur fordert BCBS 239 eine klare Benennung von Verantwortlichkeiten für die Datenqualität auf Fach- und IT-Seite.

Doch unsere unter 167 Fach- und Führungskräften deutscher Banken durchgeführte Studie zeigt gerade in den Verantwortlichkeiten noch große Mängel auf. In 29 Prozent der Banken sind keine Mitarbeiter durchgängig als Daten- und Prozessverantwortliche benannt und mit den erforderlichen Durchsetzungskompetenzen ausgestattet. Wenn sich keiner verantwortlich fühlt, gerät die Datenqualität zum Randthema. In 45 Prozent der Banken erfolgt keine durchgängige Messung und Behandlung der Datenqualität. Unter den Sparkassen haben 61 Prozent hier noch Nachholbedarf. Verschärft wird diese Situation dadurch, dass 20 Prozent der befragten Institute ihre zu Grunde liegenden Daten nicht regelmäßig korrigieren. Werden Qualitätsmängel weder gemessen noch korrigiert, erfolgen die Berechnungen im Risikomanagement teilweise aufgrund fehlerhafter Daten. So erhalten die Führungskräfte auch einen falschen Eindruck von dem Zustand ihres Geldhauses – beispielsweise hinsichtlich der Reaktionsfähigkeit auf Krisensituationen. Daher besteht hier dringender Handlungsbedarf.

Datenqualität ist in erster Linie ein prozessuales Thema. Es sollte somit dringend in den Prozessen festgelegt werden, wer für die Qualität erzeugter Daten verantwortlich ist. Zu empfehlen ist, die Qualität der Daten zusätzlich bei der Befüllung des Data Warehouses im Rahmen der ETL-Verarbeitung (Extract, Transform, Load) zu sichern. Das Datenqualitätsmanagement-System muss darauf ausgerichtet werdenanhand von hinterlegten Schwellwerten laufend die Qualität zu messen. Bei zu großer Abweichung der vorliegenden Daten von den Referenzdaten Initiiert das System eine Prüfungsanforderung durch einen Verantwortlichen.

Kopfloses Datenmanagement – fehlende Governance

Die Data Governance bezeichnet die Steuerung der Daten im Geldhaus. Dies geschieht durch die Formulierung von Regeln und der Schaffung von Entscheidungsstrukturen. Die Data Governance kann somit auch als der steuernde Kopf des Datenmanagements interpretiert werden. Ihre wichtigste Aufgabe ist dabei das Herunterbrechen und Umsetzen der Datenstrategie bis hinunter auf die Ebene, in der die Daten erstmalig erzeugt werden. Eine durch das Management formulierte Strategie soll den Führungskräften eine klare Orientierung zum Handeln geben. Sie muss jedoch auch auf Sachbearbeiterebene verankert werden und so zum verantwortungsvollen Umgang mit Daten bereits bei deren Erfassung führen.

Doch an beiden Enden mangelt es noch. Zwar geben neun von zehn der befragten IT-Führungskräfte an, dass in ihrem Institut eine Data Governance vorhanden ist. Doch oft sind die darin enthaltenen Regeln nicht auf den relevanten organisatorischen Ebenen verankert. Die gesamthafte Verantwortung für Data Governance liegt beim Vorstands und darf nicht delegiert werden. In der Praxis passiert dies jedoch zu oft. Laut der Studie trägt die Führungsebene F1 nicht selten die Hauptverantwortung und hat zudem eine höhere Kenntnis von den Data-Governance-Regeln und Prozessen als der Vorstand. Oftmals wird die Verantwortung sogar noch weiter nach unten abgegeben. Erfahrungen bei anderen Regularien zeigen, dass Steuerungsthemen von Bankvorständen oftmals so lange hinten an gestellt werden, bis konkreter Handlungsdruck sie zwingt, sich damit zu befassen. Bisher erscheint den nicht systemrelevanten Instituten das gesamte Thema Datenmanagement noch nicht drängend genug, speziell Governancethemen werden von den Entscheidern nicht stringent angegangen. Dies schwächt die Wirksamkeit der darunterliegenden Management-Prozesse und im Kontext von BCBS 239 die Fähigkeit zu einem effektiven und effizienten Risikodatenmanagement. Zudem ist in den MaRisk bereits klar festgelegt, dass die Vorstände für die Erarbeitung, Pflege und Umsetzung der Strategien verantwortlich sind.

Auch auf anderen Ebenen herrscht noch zu viel Unwissen. Die Regeln für den Umgang mit Daten sollten in der Firmen-IT breitflächig bekannt sein, denn hier erfolgt schließlich die Datenverarbeitung. Die Grundlagen für deren Qualität werden dort gelegt. Doch nur bei 13 Prozent der Befragten unterhalb der F2-Ebene ist Wissen zur Datenqualitätsprozessen vorhanden. Auch hier besteht dringender Handlungsbedarf. Es müssen geeignete Kommunikationsmaßnahmen entwickelt werden, durch die jeder Mitarbeiter über die für ihn relevanten Schritte zum Beitrag zur Erhöhung und Erhaltung der Datenqualität informiert wird.

Anspruch und Wirklichkeit

Ein erstrebenswerter einheitlicher Datenhaushalt ist optimalerweise technisch durch ein Data-Warehouse-System zu verwirklichen, in dem die Daten der vielen heterogenen IT-Systeme integriert werden. Von dort müssen die Daten auch beispielsweise für das Rechnungswesen verfügbar sein. Und das auch noch, wenn die Anforderungen und Datenmengen in Zukunft steigen. Im Durchschnitt glaubt jedoch nur ein Drittel der Institute, dass die eigene Architektur zu Risiko-Aggregation und -Reporting die aktuellen und zu erwartenden Anforderungen erfüllen kann. Nur 29 Prozent geben an, die Architektur kann problemlos zusätzliche Marts mit neuen Berichtsdimensionen aufnehmen, 34 Prozent halten ihre IT-Architektur für flexibel anpassbar. Von dem Idealbild eines BCBS-239-gerechten Datenmanagements (siehe Grafik) sind die meisten Institute noch weit entfernt.

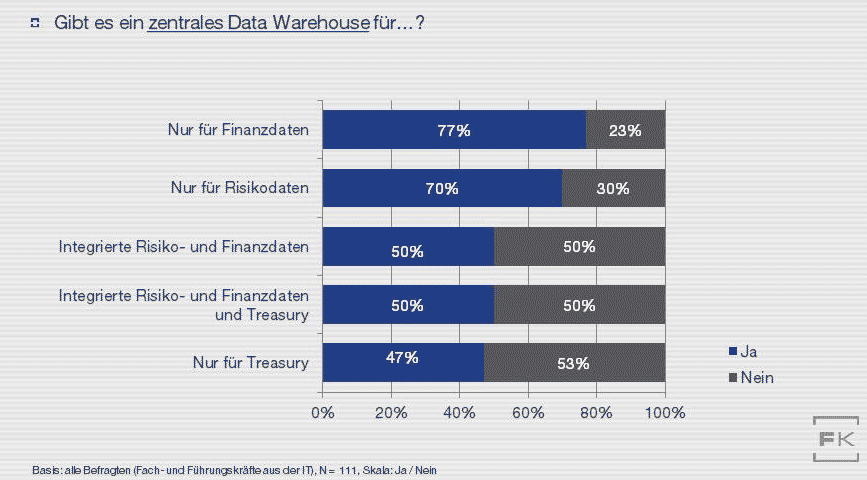

Eine integrierte Datenhaltung für Risiko- und Finanzdaten ist nur bei der Hälfte der Institute vorhanden. Jedes zweite Geldhaus hat kein Data Warehouse, das den Anforderungen entspricht. Drei Viertel der Banken bestücken ihr Data Warehouse nur mit Finanzdaten – Risikodaten und Informationen aus dem Bereich Treasury bleiben außen vor (siehe Grafik).

Problematisch ist auch, dass ausgerechnet das Metadatenmanagement noch unterentwickelt ist in den Instituten. Doch gerade dieses gewährleistet, dass Informationen im Data Warehouse schnell und sicher aufgefunden und weitgehend autonom verwendet werden können. Metadaten liefern den Hintergrund, woher die Daten stammen, wie sie weiterverarbeitet und zusammengefasst wurden. Im Sinne von BCBS 239 müssen auch die hinter den Risikoberichten stehenden Metadaten vollständig vorliegen, das erleichtert die interne Verarbeitung sowie die Prüfung durch die Aufsicht. Eine Metadatenverwaltung ist bei 27 Prozent der Banken nicht vorhanden, unvollständig oder erfolgt nur manuell. Zudem bestehen auch in den nach Themen strukturierten Bereichen der Warehouse Architektur noch Unklarheiten über die Datenherkunft. Bei 56 Prozent der befragten Banken existieren zu verwendeten Datamarts nur unvollständige Metadaten.

Je später BCBS-239 in Angriff genommen wird …

Für Kreditinstitute, egal welcher Größe, wird es Zeit, sich ausführlich mit BCBS 239 zu befassen. Auch wenn ihnen vermutlich noch eine Umsetzungsfrist bleibt, kann sich kein Institut leisten, das Thema zwei Jahre hintenanzustellen und in letzter Sekunde zu beginnen. Die Qualität der oft noch unvollständigen und unstrukturierten Daten in den Griff zu bekommen braucht Zeit. Die Prozesse im Haus zu etablieren wird mindestens ein Jahr in Anspruch nehmen. Vor allem die Vorstandsebene darf die Augen nicht mehr vor dem den anstehenden Herausforderungen im Datamanagement verschließen und muss sich persönlich mit der Data-Governance beschäftigen. Zudem bieten qualitativ hochwertige und transparent erzeugte Daten auch jenseits der Regulierung im internen Gebrauch weitere wirtschaftluche Vorteile.

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/9566

Schreiben Sie einen Kommentar