Wie BI 4.0 die IT und Fachbereiche vereint und einen Paradigmenwechsel einleitet

Data Virtuality

Business Intelligence (BI) hat über viele Generationen hinweg unzählige Veränderungen und Erweiterungen erfahren. So auch in jüngster Vergangenheit: Technologischer Fortschritt und Innovationen im Bereich Big Data, Cloud Computing, Analytics und Künstliche Intelligenz (KI) haben eine neue Dynamik auf dem BI-Markt entfacht. Die Möglichkeiten der modernen Technologien beflügeln immer neue Geschäftsideen und theoretische Einsatzfelder. Sie wecken Hoffnung auf die nächste digitale Revolution. Es winkt eine schöne neue Welt, angeführt von Technologie-Enthusiasten.

von Dr. Nick Golovin, Gründer und CEO der Data Virtuality

In dieser neuen Welt von “Data Analytics” und “Big Data”, angeführt durch die Business-Seite, scheint für klassische Business Intelligence kein Platz mehr zu sein. Tatsächlich wird bereits kolportiert, dass BI tot sei. Doch ganz so einfach ist es nicht. Denn eine zentrale Steuerung der “Data Supply Chain” in Unternehmen wird aufgrund der Marktentwicklungen immer wichtiger und eine an die neuen Gegebenheiten angepasste “Business Intelligence 4.0” könnte die Lösung für viele aktuelle Herausforderungen sein.Business Intelligence früher und heute

BI 2.0-Systeme wie Cognos, BusinessObjects oder MicroStrategy waren klassisch dreistufig: 1. Storage (Data Warehouse (DWH), Datenspeicher), 2. Semantic Layer (Universes, Frameworks, Schema Objects, Information Maps etc.) und 3. Frontend, also die grafische Datenanalyse-Oberfläche.

Aktuell sind meist BI 3.0-Systeme im Einsatz. Sie sind geprägt von starken Veränderungen bei den Frontends und auf der Storage-Seite. Die neuen Frontends sind für Self-Service-BI ausgelegt, angeführt von Spezialisten für Datenvisualisierung wie Tableau, Microsoft Power BI oder Qlik. Aufgrund der technologischen Entwicklung im Bereich Big Data mit wesentlich mehr nutzbaren Datenquellen und -arten gibt es außerdem wesentlich mehr Storage-Optionen, also eine größere Vielfalt an Datenspeichern, die oft parallel eingesetzt werden – neben dem klassischen Enterprise-DWH auch Cloud-Datenbanken, Data Lakes, NoSQL- und Graphdatenbanken sowie weitere Lösungen.

Der Semantic Layer wird in BI 3.0 kaum eingesetzt. Doch Rufe nach Veränderung werden laut. Die steigende Komplexität der Datenlandschaft gepaart mit mehr Möglichkeiten der Datenverarbeitung führt dazu, dass es aktuell keinen Konsens bzw. eine einheitliche Lösung der Herausforderungen gibt. Chaotische Zustände in der Data Supply Chain sind die Folge.

Das führt zu erheblichen Beeinträchtigungen auf der Business-Seite, wenn Anwender mit falschen, unvollständigen oder inkonsistenten Daten arbeiten müssen.”

So arbeiten viele Unternehmen beim Reporting weiterhin in Microsoft Excel: 75 Prozent nutzen es für die Planung oder setzen Excel zumindest parallel zu speziellen Softwarelösungen für die Planung ein. Ein häufig daraus resultierendes Problem ist, dass einzelne Business-Stakeholder die Daten manuell in Excel bearbeiten (Stichwort Datenkonsistenz) und Änderungen für andere nicht nachvollziehbar sind.

BARC

Der Graben zwischen IT und Business ist nach wie vor vorhanden

Bei dem Hype um die neuen Technologien wird übersehen, dass sie kein Ersatz für Business Intelligence sein können. Denn BI hat einen direkten Bezug und Zweck im Tagesgeschäft und beeinflusst die Ausrichtung und Entwicklung eines Unternehmens unmittelbar.

Wie wichtig dieser Aspekt tatsächlich ist, wird in Anwenderunternehmen deutlich: Steigender Wettbewerbsdruck und die Auswirkungen des digitalen Wandels führen zu einem wachsenden Bedarf an Daten in Business-Abteilungen. Aufgrund immer besserer Self-Service-BI-Lösungen arbeiten Anwender inzwischen oft völlig autark von der IT mit Daten. Die Gefahr: IT und Business arbeiten aneinander vorbei. Der steigende Daten- und Analysebedarf der Anwender wird nicht von technologischen Entwicklungen im IT-Bereich begleitet. Und diese Lücke wird auch aufgrund der ständig neuen technologischen Ansätze – sowohl für Business User als auch für die IT – immer größer.

Es bedarf einer neuen Generation von BI, um die beiden Lager auf breiter Front wieder zusammenzubringen. Denn nur gemeinsam können die Herausforderungen der neuen BI-Welt gemeistert werden.”

So besagt eine aktuelle Prognose von Gartner, dass bis zum Jahr 2023 bis zu 60 Prozent aller Unternehmen von Enterprise-Architekten abhängig sein werden, wenn es um digitale Innovationen geht. Dabei wird die Position des Enterprise-Architekten neu definiert und jenseits der technischen auf geschäftliche Zusammenhänge erweitert.

So verändert „Big Data“ Business Intelligence

In den letzten Jahren sind eine Vielzahl neuer und teils offener Datenquellen verfügbar geworden, die Unternehmen in ihre Datensätze einfließen lassen und analysieren können. Auch gibt es immer mehr Möglichkeiten, selbst Daten zu erheben, zum Beispiel Sensordaten oder Daten von Internet-of-Things(IoT) -Geräten. Diese Datenflut kann mit den alten Systemen und Methoden nicht mehr bewältigt werden, sei es auf Hardware- oder auf Software-Seite.

Es werden ständig Systeme und Methoden weiterentwickelt, um „Big Data“ zu bewältigen. Aber gerade aufgrund der tatsächlich unbegrenzten Datenmenge, die man inzwischen theoretisch verarbeiten und analysieren kann, sollte klar sein, dass die IT hier nicht die alleinige Steuerung übernehmen kann. Technische Anforderungen müssen immer aus konkreten Business Cases heraus kommen und sollten von der BI gesteuert werden. Nur so ist gewährleistet, dass Daten gezielt und gewinnbringend in Geschäftsprozessen genutzt werden.

Wir konnten in vielen Kundenprojekten beobachten, wie die Business Intelligence Teams innerhalb der Organisation an Bedeutung gewannen, wenn sie den Anwendern die Daten schnell und flexibel zur Verfügung stellen konnten.”

So stieg beispielsweise die Nachfrage nach verschiedenen Daten und somit auch das Vertrauen in das Data Management Team bei unserem Kunden Crédit Agricole Consumer Finance NL, nachdem sie die Architektur so geändert hatten, dass ein flexibler Datenfluss möglich war. Waren sie vorher als reine Reporting-Abteilung am Ende der Data Supply Chain, sind sie nun Teil von Entscheidungsprozessen bei der Geschäftsentwicklung.

So verändert das Cloud Computing die Business Intelligence

Cloud-Plattformen konnten in den letzten Jahren einen starken Aufschwung verzeichnen und sich als fester Bestandteil in vielen Unternehmen etablieren. Auch Finanzinstitutionen werden aufgrund der Veröffentlichung der gelockerten Richtlinien im Rahmen der Bankenregulierung durch die Aufsichtsbehörden die Nutzung von Cloud-Diensten verstärken.

Die großen Vorteile von Cloud-Plattformen sind die Rechenpower, Skalierbarkeit, Flexibilität und der schnelle Datenzugriff (auch bei großen Datenmengen) für viele verschiedene Nutzer. Hiervon profitieren vor allem auch die BI-Abteilungen, da sie so schnell und einfach auf ihre Daten zugreifen und sie weiterverarbeiten können.

Dr. Nick Golovin ist der Gründer und CEO von Data Virtuality (Website). Vor der Gründung des Unternehmens arbeitete Nick mehr als zehn Jahre an vielen umfangreichen Datenintegrationsprojekten im internationalen Umfeld. Er promovierte an der Universität Leipzig, Deutschland, zum Thema Datenintegration, Data Warehousing und Machine Learning.

Dr. Nick Golovin ist der Gründer und CEO von Data Virtuality (Website). Vor der Gründung des Unternehmens arbeitete Nick mehr als zehn Jahre an vielen umfangreichen Datenintegrationsprojekten im internationalen Umfeld. Er promovierte an der Universität Leipzig, Deutschland, zum Thema Datenintegration, Data Warehousing und Machine Learning.Jedoch sind viele Datenverantwortliche berechtigterweise noch sehr zurückhaltend, hochsensible Kundendaten oder Finanzkennzahlen in die Cloud zu verlagern, da weiterhin einige Fragen zur Datensicherheit, Regulierung und Risiken durch Auslagerung kritischer Prozesse noch offen sind. Weiterhin muss das Augenmerk auf Data Governance und Datenqualität auch bei der BI in der Cloud gelegt werden. Eine flexible Datenmanagementstruktur ist eine Voraussetzung hierfür.

Aus diesen Gründen geht der Trend zu Hybrid- und Multi-Cloud Architekturen, in denen die Daten auf verschiedene Cloud-Anbieter und on-premises Anwendungen verteilt wird. So kann einerseits die neu gewonnene Flexibilität in der BI gewahrt werden und andererseits die Risiken und Herausforderungen minimiert und verteilt werden.

So verändert Advanced Analytics BI

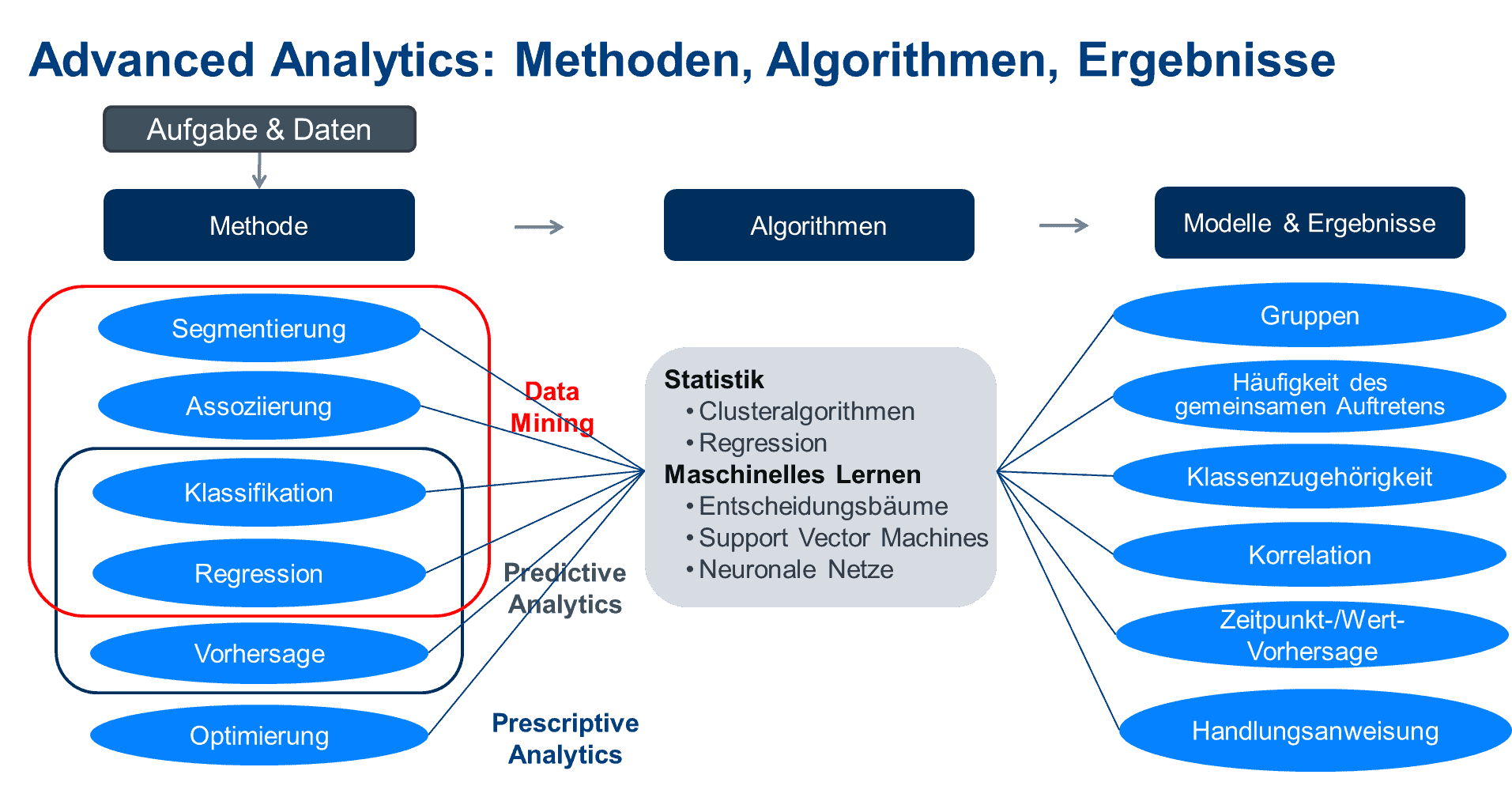

Business Intelligence profitiert von “Advanced Analytics” mit seinen relativ neuen Analysetechniken und -methoden. Predictive und Prescriptive Analytics helfen Unternehmen in vielen konkreten Anwendungsfällen dabei, beispielsweise Prozesse, Supply Chains oder Gerätewartung zu optimieren (siehe Abbildung 2).

Für eine erfolgreiche Umsetzung von Advanced-Analytics-Initiativen muss jedoch die Datenbasis stimmen. Maßnahmen für Data Governance und Datenqualität müssen weiterhin von einer zentralen Einheit gesteuert werden. Das könnte natürlich theoretisch die IT sein. In der Praxis ist die BI-Abteilung mit ihrem Fokus auf konkrete Anwendungsfälle für solche Maßnahmen prädestiniert oder es sollte zumindest eine enge Zusammenarbeit von BI und IT gewährleistet sein.

BARC

So verändert Künstliche Intelligenz BI

Machine Learning und KI sind schon lange fester Bestandteil der Business Intelligence (siehe Abbildung 1). Der Fortschritt der letzten Jahre im Bereich Künstliche Intelligenz ist beachtlich. BI profitiert immens davon. Eine Chance liegt dabei zum Beispiel in den vielfältigen Möglichkeiten der Automatisierung von Prozessen. So kann die oben beschriebene Datenflut eventuell bewältigt werden. Das erklärt auch das hohe Interesse an KI-Lösungen bei Anwenderunternehmen, Analysten und Medien.

Für KI und neuronale Netzwerke sind neben ausgefeilten Algorithmen eine solide Datenbasis sowie eine hundertprozentige Data Governance und Datenqualität extrem wichtig. Eine zukunftsfähige BI-Architektur ist Voraussetzung hierfür. Eine einzige Single Source of Truth für Data Scientists und Business-Analysten sowie anderen Datenkonsumenten ist mittlerweile ein Muss, da nur so eine effiziente und nachhaltige Datennutzung möglich ist.

Business Intelligence 4.0 ordnet die Data Supply Chain

BI 4.0 wird von Veränderungen im Semantic Layer und der Data Supply Chain geprägt sein. Mehr Daten und Datenquellen sowie eine größere Datenvielfalt bedingen, dass Anwenderunternehmen besonders Themen wie Data Governance, Data Lineage oder Metadata-Management adressieren und so Kontrolle, Konsistenz und Transparenz ihrer Daten gewährleisten. Um diese Komplexität zu meistern, setzen Unternehmen aktuell häufig auf Metadata-Catalogs. Das ist ein Schritt in die richtige Richtung. Aber eigentlich stellen sie eine unzureichende Lösung dar, denn Metadata-Catalogs steuern nicht den eigentlichen Datenfluss und laufen meist als autarke Systeme. Sie sind als Nachschlagewerk nützlich, sind aber selbst nicht Teil der Data Supply Chain.

BI 4.0 in der Finanzbranche

Die Finanzbranche war schon immer ein “early adopter” neuer BI- und Datenmanagement-Ansätze. Bereits jetzt zeichnet sich ab, dass dies beim Einsatz von BI 4.0 wieder der Fall sein wird. Ein wichtiger Treiber dahinter sind die regulatorischen Anforderungen wie BCBS239, Solvency II oder DSGVO. Sie zwingen Unternehmen der Finanzbranche dazu, besonders sorgfältig mit ihren Daten umzugehen. Der Druck seitens der Aufsichtsbehörden erzeugt ständig neue Use Cases für innovative BI- und Datenmanagement-Technologien.

Die neuen digitalen Geschäftsmodelle und die damit verbundene Explosion an unterschiedlichen Datenquellen, Cloud Services und Technologien führen dazu, dass neue Wege gefunden werden müssen, um diese Datenvielfalt in die Data Supply Chain zu integrieren, sie zu verarbeiten und zu analysieren.”

Ein weiterer wichtiger Treiber der Innovationen sind wie immer die Kosten. Mit neuen Technologien ist es häufig möglich, mehr produktive Ergebnisse mit weniger Mitteln zu erreichen.

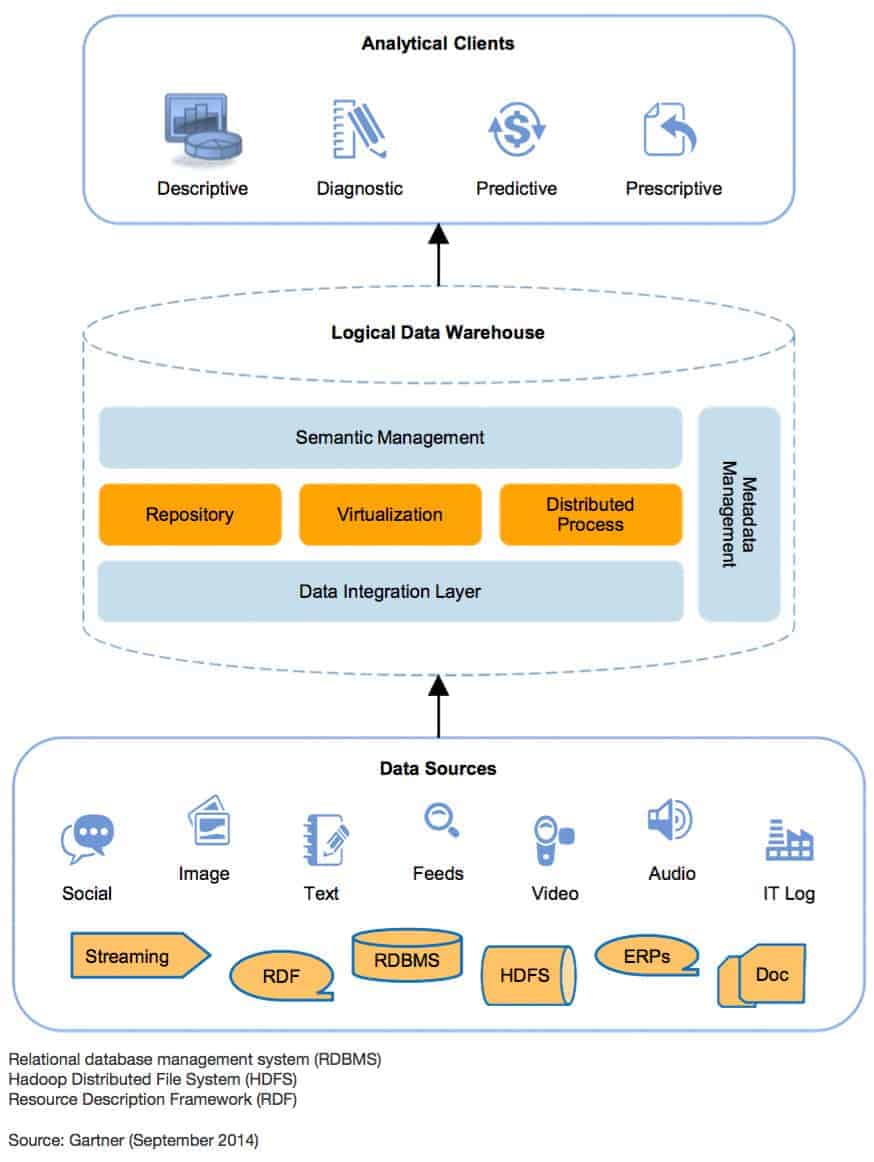

Das Logical Data Warehouse als zentrale Komponente von BI 4.0

Eine Lösung für die oben beschriebenen Herausforderungen der BI 4.0 stellt das Logical Data Warehouse (LDW) dar. Basierend auf der Technologie der Datenvirtualisierung vereint es als eigenständige Komponente die Vorteile von Self-Service-BI mit robusten Backend-Lösungen (Data Lake, DWH, etc.), flexibler Datenarchitektur mit Hybrid- oder Multi-Cloud und umfangreichen Data-Governance-Funktionen (siehe Abbildung 3).

Vorteile des Logical Data Warehouse sind unter anderem die äußerst schnelle Integration neuer Datenquellen, die agile Dateninfrastruktur, der Echtzeit-Datenzugriff und die kurzen Implementierungszeiten.”

Das LDW als “single source of truth” ist angepasst an die mit den neuen Technologien entstehenden Anforderungen an moderne BI- (4.0) und IT-Systeme. Mit dem Logical Data Warehouse können Unternehmen also solide, zukunftsfähige BI-Architekturen bauen, welche die Kluft zwischen Anwendern und IT schließen sollten.

Nicht alleine der Einsatz von Hype-Technologien wie Cloud und KI wird entscheiden, welche Unternehmen als Gewinner aus der digitalen Transformation hervorgehen und welche auf der Strecke bleiben. Viel mehr wird es die Fähigkeit sein, Daten und Systeme zur Datenverarbeitung effektiv auf breiter Front für konkrete geschäftliche Anwendungsfälle und Herausforderungen zu nutzen. Um das zu erreichen, müssen IT und Business eng und zielgerichtet zusammenarbeiten und so mit Business Intelligence 4.0 einen Paradigmenwechsel einleiten.Dr. Nick Golovin, Data Virtuality

Gartner

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/107705

Schreiben Sie einen Kommentar