Finastra: 5-Punkte-Plan gegen Frauendiskriminierung durch Algorithmen und KI

Auch die Finanzindustrie ist nicht frei von geschlechtsspezifischen Vorurteilen. Wo Entscheidungen auf Algorithmen und KI-Agenten verlagert werden, besteht die Gefahr, dass diese Voreingenommenheit übernommen wird. Finastra plädiert an die gesamte Finanzbranche, sich dieses Problems bewusst zu werden – und geht bei der Bewältigung mit einem 5-Punkte-Plan voran.

KPMG

Im August 2019 startete Apple zusammen mit Goldman Sachs eine eigene Kreditkarte – die Apple Card. Es dauerte nur wenige Monate, da ergoss sich ein Shitstorm über das Unternehmen. „Die Apple Card ist verdammt sexistisch“ wetterte etwa David Heinemeier Hansson, der Gründer der US-Softwarefirma Basecamp, auf Twitter. Obwohl er mit seiner Frau gemeinsam zur Steuer veranlagt werde und sie sogar ein besseres Kreditscoring habe als er selbst, sei sein Kreditrahmen 20 mal größer als der seiner Gattin. Es meldeten sich weitere – teils prominente – Kunden der Apple Card, die ähnliche Erfahrungen gemacht hatten, darunter auch Apple-Mitbegründer Steve Wozniak.

Goldman Sachs behauptete zwar, bei der individuellen Prüfung spiele das Geschlecht keine Rolle. Doch weltweit klagen Frauen über ähnliche Erfahrungen. Verbraucherkredite seien seltener zu erhalten oder nur in geringer Höhe als bei männlichen Antragsstellern, gleiches gelte beim Einräumen von Überziehungsrahmen bei Konten und Kreditkarten. Dazu kämen schlechtere Konditionen, die man(n) den Frauen gewährt.

Gegen digitalisierte Vorurteile

In den Anfangstagen der künstlichen Intelligenz herrschte Optimismus: Auf Basis objektiver Kriterien würden die Maschinen diskriminierungsfrei entscheiden und damit eine fairere, gerechtere Welt ermöglichen. Inzwischen zeigt sich, dass das Gegenteil der Fall ist. Herrschende Vorurteile finden als Bias Eingang in die zunehmend autonomer entscheidenden Algorithmen – und setzen die Diskriminierungen der Vergangenheit auch im Rahmen der digitalen Transformation fort.

Rechtzeitig zum Internationalen Frauentag am 8. März – und dem Equal Pay Day zwei Tage später – fordert Finastra, eines der weltweit größten FinTechs, nun die globale Finanzindustrie auf, gegen solche algorithmische Voreingenommenheit vorzugehen. Wahrscheinlich seien täglich Millionen von Menschen betroffen, so das Unternehmen.

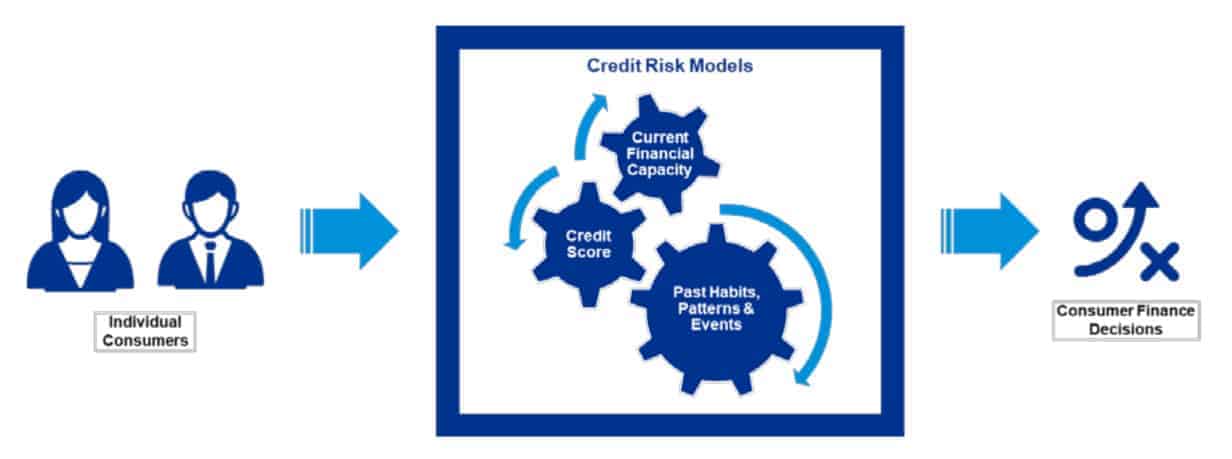

Einsatz von Algorithmen in der Finanzindustrie

Um das Problem besser zu verstehen, beauftragte Finastra KPMG mit der Erstellung eines Berichts, der die Marktgröße für Verbraucherkredite und die möglichen Auswirkungen algorithmischer Voreingenommenheit untersucht. Im Jahr 2020 betrug das Volumen der beantragten Verbraucherkredite und -transaktionen (Kreditkarten, andere Verbraucherkredite und Hypotheken-/Hauskredite) über:

- 6.110 Mrd. $ in den USA

- 1.270 Mrd. HK$ in Hongkong

- 440 Mrd. £ im Vereinigten Königreich

- 280 Mrd. € in Frankreich

- 110 Mrd. SG$ in Singapur

Sowohl die Bereitstellung als auch die Kosten dieser Kredite für die Verbraucher, zum Beispiel die erhobenen Zinssätze, werden in vielen Fällen von den verwendeten Algorithmen bestimmt.

Der Bericht fasst aktuelle Erkenntnisse zu algorithmischen Vorurteilen zusammen und zeigt zudem die Auswirkungen von voreingenommenen Entscheidungen auf. Die Ergebnisse des Berichts für Finastra machten deutlich, dass Anbieter bei der Entwicklung, Erstellung und Implementierung von Algorithmen sorgfältig vorgehen müssen, räumt Dr. Leanne Allen, Director bei KPMG Financial Services Tech Consulting, ein.

KPMG

„In unserer digitalen und datengesteuerten Welt ist es von entscheidender Bedeutung, Vorurteile zu vermeiden. Wenn wir dies nicht tun, besteht die Gefahr, dass wir Verbrauchern, die auf bestimmte Dienste angewiesen sind, ernsthaften finanziellen Schaden zufügen.“

Leanne Allen, KPMG in the UK

Konkrete Maßnahmen angekündigt

Finastra-Chef Simon Paris warnt deshalb davor, dass der zunehmende Einsatz von KI zu einem Katalysator von Vorurteilen in Algorithmen werden können, wenn die Finanzbranche dieses Problem nicht mit hoher Priorität angehe. Erklärtes Ziel seines Unternehmens sei es sicherzustellen, dass Finanztechnologie in jeder Hinsicht fair ist, indem sie bei der Kreditvergabe gleiche Voraussetzungen schafft, bekräftigte Paris.

Finastra

„Finastra hat nicht alle Antworten, aber wir glauben, dass die Branche zunächst erkennen muss, dass es ein Problem mit algorithmisch bedingten Benachteiligungen gibt – nur dann können wir gemeinsam an einer Lösung arbeiten. Wir werden mit unseren Partnern und unserem Ökosystem zusammenarbeiten, um den notwendigen Wandel in der Branche voranzutreiben. Gemeinsam können wir die Finanzbranche neu definieren und für alle zugänglich machen.“

Simon Paris, CEO von Finastra

Gemeinsam mit KPMG hat Finastra einen 5-Punkte-Plan entwickelt, der dazu beitragen soll, die Finanzwelt neu zu definieren:

- Aktualisierung von Finastras Entwicklervereinbarung: Finastra hat seine Entwicklerbedingungen für FusionFabric.cloud, seine offene Plattform und Marktplatz für Entwickler, aktualisiert. Von Entwicklern und Partnern wird erwartet, dass sie algorithmische Vorurteile berücksichtigen. Finastra behält es sich vor, jede neue Anwendung auf algorithmische Benachteiligung zu überprüfen.

- Schaffung neuer Proof-of-Concept-Technologien: FinEqual hat ein digitales Tool, das eine vorurteilsfreie Kreditvergabe ermöglicht, entwickelt, um Nutzern eine Technologie an die Hand zu geben, mit der sie algorithmisch bedingte Benachteiligung in ihren Unternehmen beseitigen können. Finastra befindet sich derzeit im Proof-of-Concept-Stadium und will die Lösungen von FinEqual in den nächsten 18 Monaten für Kunden verfügbar machen.

- Hacking for good: Finastra verpflichtet sich, dass alle zukünftigen Hacks einen Fokus auf Inklusion haben. Um dies zu unterstützen, wird Finastra einen globalen Hacking-Wettbewerb als Teil seiner “Hack to the Future”-Reihe starten, um weibliche Talente in der Branche ins Rampenlicht zu rücken, indem ausgewogene, von Frauen geführte Teams gefunden und ausgezeichnet werden, die die Grenzen von KI und maschinellem Lernen ausloten.

- Gleichberechtigung am Arbeitsplatz: Innerhalb der Organisation setzt Finastra sein Vorhaben auf ein Verhältnis von 50:50 zwischen Männern und Frauen zu kommen, fort. Dies beinhaltet die Erhöhung des Frauenanteils unter den Top-200-Führungskräften und Ingenieuren von 30 Prozent auf 40 Prozent bis 2025 und auf 50 Prozent bis 2030.

- Zusammenarbeit mit Regulierungsbehörden: Finastra hat sich verpflichtet, KI-Voreingenommenheit zu beseitigen. Das Unternehmen arbeitet eng mit Aufsichtsbehörden in mehreren Märkten zusammen und fordert als Technologieführer die Finanzdienstleistungsbranche auf, die Auswirkungen von algorithmisch bedingter Benachteiligung zur Kenntnis zu nehmen.

Der vollständige Bericht von KPMG steht auf der Finastra-Website zum kostenlosen Download bereit. hj

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/118315

Schreiben Sie einen Kommentar