Intelligentes Daten- und Dokumentenmanagement in der Bank mit BCBS 239 und MaRisk 14

Neue Lösungen ermöglichen die Prüfung und Validierung von Stamm- und Bewegungsdaten am Front-End von Bankprozessen. So erleichtern sie die Einhaltung von Regularien wie BCBS 239 und MaRisk 14 und erschließen zudem zusätzliche Potenziale. Alexandre Janicki (Lexmark) hat die Anforderungen und möglichen Lösungswege gut verständlich für IT Finanzmagazin zusammengefasst.

von Alexandre Janicki, Senior Industry Consultant Financial Services bei Lexmark

Wir alle wissen – ab 2016 wird es ernst: Denn in einigen Monaten müssen Banken in Deutschland die „Grundsätze für die effektive Aggregation von Risikodaten und die Risikoberichterstattung“ umsetzen, die der Baseler Ausschuss für Bankenaufsicht (BCBS) 2013 veröffentlicht hat („BCBS 239“). Konkret bedeutet das: Die Geldhäuser müssen ihre IT-Systeme und -Prozesse so umstellen, dass diese das Risikomanagement der Unternehmen bestmöglich unterstützen.Im Kern geht es dabei um die Frage, wie Banken mit den von ihnen verwalteten Daten umgehen, genauer, wie sie Qualität und Integrität von Daten und Datenverarbeitungsprozesse gewährleisten. Denn daran gibt es nach Ansicht des BCBS noch immer einiges auszusetzen. In einem Papier des Ausschusses heißt es: „One of the most significant lessons learned from the global financial crisis that began in 2007 was that banks’ information technology (IT) and data architectures were inadequate to support the broad management of financial risks” – Mängel in Datenverwaltung und -verarbeitung haben das Entstehen der Krise demnach begünstigt.

13 Regeln: Bessere Daten, besseres Risikoberichtswesen

Damit das nicht noch einmal vorkommt, hat der BCBS in „Grundsätze“ 13 Regeln dargestellt. Diese schreiben vor, wie Banken künftig Daten sammeln, speichern, verwalten und vor allem auswerten sollen, um Risiken zu vermeiden oder frühzeitig zu erkennen. Die Regeln beziehen sich auf die Bereiche Governance und Infrastruktur für das Datenmanagement, Regeln über das richtige Aggregieren von „Risikodaten“, Strukturen und Prozesse des Risikoberichtswesens sowie regulatorische Prüfungen und die Zusammenarbeit mit den Aufsichtsbehörden. Die Mehrzahl der Regeln zielt darauf ab, die Vollständigkeit, Genauigkeit, Aktualität und Integrität der Daten zu erhöhen, mit denen Banken täglich arbeiten. Das soll die Zuverlässigkeit des Risikoberichtswesens der Geldhäuser erhöhen.

Datenprüfung und -Berichtigung erfolgt oft „zu weit hinten“

Doch sollte der Zusammenhang, dass bessere Daten zu einem besseren Risikomanagement führen, nicht längst bekannt und berücksichtigt sein? Tatsächlich wissen die Risk-Manager der Banken natürlich schon seit jeher um die Bedeutung der Datenverwaltung. Doch diese zu optimieren, hat sich in der Umsetzung fast immer als schwierig erwiesen. Einer Selbsteinschätzung zufolge hatten US-amerikanische und europäische Banken noch 2014 mit Mängeln bei Datenqualität und zeitnaher Datenlieferung zu kämpfen. Besonders die Automatisierung der Datenaggregation und ein Plus an Flexibilität machen vielen Geldhäusern zu schaffen. Ähnliches gilt für den Abbau manueller Prozessschritte und entsprechender Schnittstellen.

Dass diese Schwierigkeiten Auswirkungen auf die Güte von Stamm- und Bewegungsdaten haben, versteht sich von selbst. Datenqualität sollte da entstehen, wo datenerzeugende Prozesse angestoßen werden: beim Erfassen und Validieren von Kunden- und Vertragsdaten beispielsweise.

Probleme in der Praxis

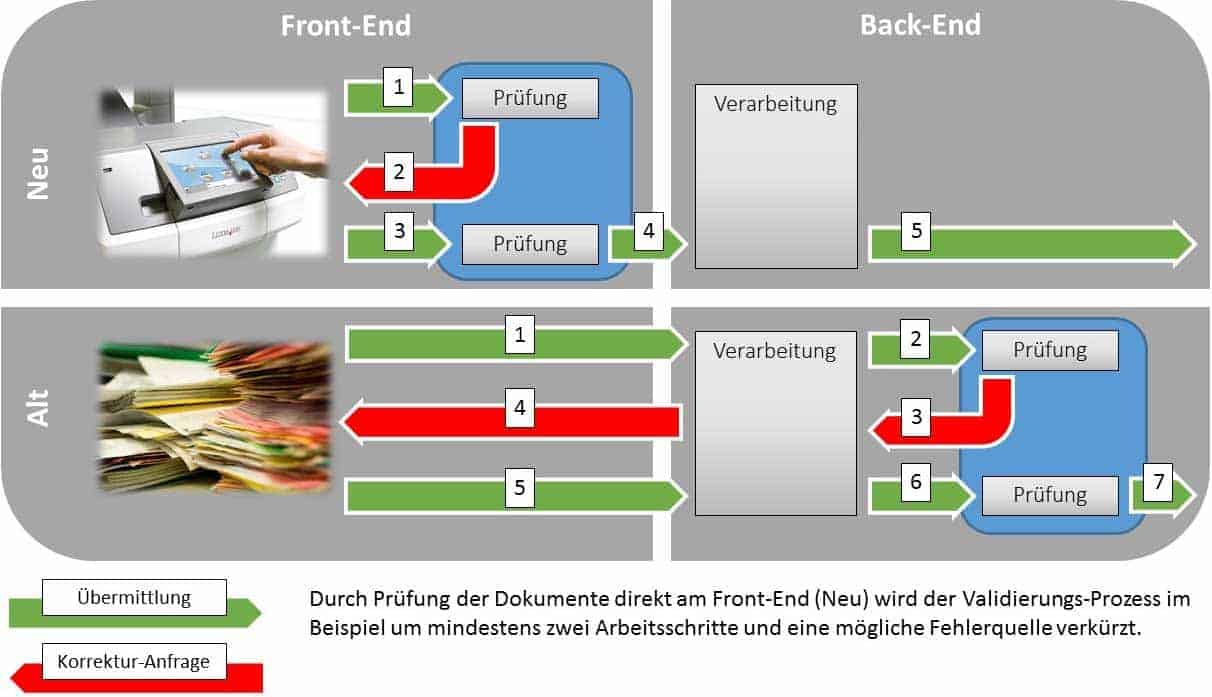

Genau hierbei haben viele Geldhäuser aber ihre Schwierigkeiten. Denn die Daten werden zwar zunehmend digital und teilautomatisch erfasst – etwa per Self-Service im Internet oder vom Bankberater und der Software, die dieser benutzt. Doch die Prüfung dieser Daten erfolgt in den allermeisten Fällen „zu weit hinten“ im Prozessverlauf. Soll heißen: Die erforderlichen Papierunterlagen gehen häufig zeitverzögert ein und werden meist in separaten Back-Offices oder Shared Services Centers bearbeitet. Das erschwert die Aufdeckung von Mängeln („Revisionsmoniten“ genannt) und verteuert deren Beseitigung erheblich.

Ein Beispiel sind Unstimmigkeiten bei den Belegunterlagen zum Online-Kreditantrag eines Kunden. Zwei Gehaltsabrechnungen zeigen Werte, die für den prüfenden Sachbearbeiter eines Shared-Services-Centers nicht nachvollziehbar sind. Er setzt sich mit dem zuständigen Berater in Verbindung, der die Auffälligkeit nicht erklären kann. Beide verständigen sich darauf, den Kunden zu einem Gespräch zu bitten. Erst vier Telefonate später kann der Kunde das Gespräch wahrnehmen, die Unstimmigkeit erklären und den Kredit erhalten.

Datenqualitätssicherung unmittelbar am Front-End

Dieses Beispiel veranschaulicht: Je ungenauer Datenerfassung und

-aggregation am Front-End oder im Front-Office sind, umso teurer werden Datenprüfung und -verwaltung im Back-End. Wäre die Unstimmigkeit schon während des Antragsprozesses aufgefallen, wäre Sachbearbeitern, Beratern und Kunden die klärende Schleife erspart geblieben. Doch wie lässt sich die Qualitätssicherung „nach vorn“ verlagern?

Mehrere Hersteller von Dokumenten- und Enterprise Content Management (ECM)-Systemen bieten Lösungen an, die Abhilfe schaffen. Lexmark hat beispielsweise ein kanalübergreifendes System aus Hard- und Software entwickelt, mit dem sich Daten nicht nur erfassen lassen sondern zugleich auch validieren. Das System stellt dem Prozesseigentümer, also beispielsweise dem Online-Banking-System oder dem Bankberater, Echtzeit-Informationen zur Qualität der erfassten Daten zur Verfügung, indem es die Daten automatisch analysiert, klassifiziert und prüft.

Beispiel:

In der Bankfililale werden die Kreditunterlagen im Beratungsgespräch sofort via Multifunktionsgerät erfasst,

dieses erkennt mittels Software automatisch, um welche Unterlagen es sich handelt, liest relevante Informationen aus (beispielsweise für die Bonitätsprüfung), prüft diese und leitet sie weiter.

Bei der Prüfung ermittelte Mängel (Beispiel: fehlende Unterschriften) werden unmittelbar am Display des Multifunktionsgeräts angezeigt.

Ausweisdokumente werden automatisch erkannt und per Betrugspräventionsroutinen geprüft.

Diese und ähnliche Lösungen tragen nicht nur dazu bei, die Fehler zu vermeiden, die an der Schnittstelle zwischen manuellen und digitalen Prozessen üblicherweise entstehen, sondern beschleunigen darüber hinaus auch sämtliche Arbeitsabläufe. Dadurch helfen sie, dass Vorgaben wie der BCBS 239 eingehalten werden und die Service-Leistung der Bank verbessert wird. Schließlich steigt nicht nur die Datenqualität im Geldhaus sondern auch die Geschwindigkeit, in der Mitarbeiter wartenden Kunden Rückmeldungen zu laufenden Aufträgen geben können.

Die Vorteile des Einsatzes von Front-End-Automationslösungen können daher sein:

Kundenzufriedenheit und -bindung steigen

Prozesse werden „schlanker“, das heißt die Prozesskosten pro Fallbearbeitung sinken.

Die verbesserte Datenqualität und Prüfung hilft, Risiken teilweise früher und schneller zu erkennen.

Das schafft Potenzial für die Optimierung der Risikomargen der relevanten Geschäfte.

Zusammengefasst hat der Einsatz von Front-End-Automatisierungslösungen für das Dokumenten- und Datenmanagement in Banken also zwei Vorteile: Sie können den immensen regulatorischen Druck auf IT und Fachabteilungen der Geldhäuser mildern. Und sie können zusätzliche Wettbewerbsvorteile erschließen.

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/11725

Schreiben Sie einen Kommentar